HTTP长连接和流水线原理是什么?什么是队头阻塞?HTTP/2多路复用如何解决队头阻塞?HTTP/3的QUIC协议做出了哪些优化

一、面试官:请说说看HTTP1.1与HTTP1.0的主要区别是什么?

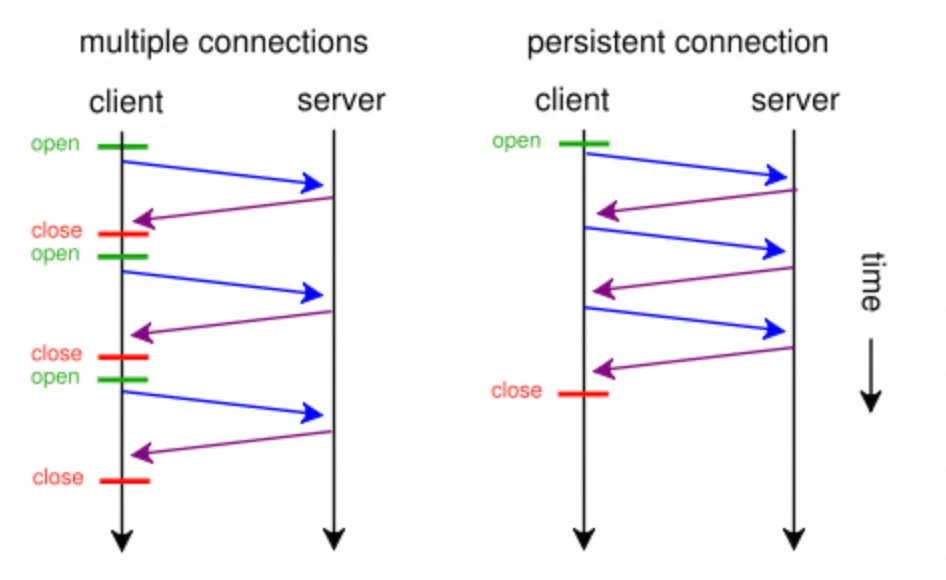

1. 连接管理:长连接与流水线处理HTTP/1.0:默认使用短连接,每次请求需建立新TCP连接,请求完成后立即关闭。若需长连接,需显式设置 Connection: Keep-Alive,但兼容性差(部分代理不支持)。

HTTP/1.1:默认启用长连接(持久连接),允许在一个TCP连接上传输多个请求/响应,减少握手开销。支持流水线(Pipelining)技术,客户端可连续发送多个请求(无需等待响应),但服务器需按请求顺序返回响应,避免队头阻塞。

HTTP/1.0:假设一个IP对应唯一服务器,请求头中无Host字段,无法支持虚拟主机技术(如多个域名共享同一IP)。

HTTP/1.1:强制要求请求头包含 Host 字段,用于标识目标服务器域名。若缺失,服务器返回 400 Bad Request,解决了虚拟主机场景下的资源定位问题。

3. 缓存机制增强HTTP/1.0:依赖 Expires(绝对时间)和 Last-Modified(最后修改时间)控制缓存,存在时钟同步问题。缓存验证通过 If-Modified-Since 实现。

HTTP/1.1:

引入 Cache-Control 头(如 max-age、no-cache),支持相对时间缓存策略。新增 ETag(实体标签)机制,通过 If-None-Match 验证资源是否变更。支持 Vary 头,根据请求头(如 Accept-Language)区分不同缓存版本。4. 带宽优化与分块传输范围请求:HTTP/1.1 支持 Range 头,允许请求资源部分内容(如断点续传),响应状态码为 206 Partial Content。

分块传输编码(Chunked Encoding):动态生成内容时,通过 Transfer-Encoding: chunked 分块传输,无需预知完整数据大小,提升传输效率。

100 Continue 状态码:客户端发送大请求前,先通过 Expect: 100-continue 头询问服务器是否接受,避免带宽浪费。

5. 错误状态码与内容协商错误状态码:HTTP/1.1 新增24个状态码,如

100 Continue:(继续请求)206 Partial Content:(部分内容)409 Conflict:(资源状态冲突)410 Gone:(资源永久删除)。内容协商:通过 Accept-* 系列头(如 Accept-Language、Accept-Encoding)支持多语言/压缩格式,服务器返回最适配版本,并通过 Vary 头记录协商依据。

6. 其他改进请求方法扩展:HTTP/1.1 新增 OPTIONS、PUT、DELETE、TRACE 等方法,支持 RESTful API 设计。

消息传递优化:支持 Trailer 头传递分块传输后的元数据(如校验和),提升大文件传输的完整性。

总结对比表:

特性

HTTP/1.0

HTTP/1.1

连接管理

短连接,需手动启用长连接

默认长连接,支持流水线

Host头域

不支持

强制要求,支持虚拟主机

缓存机制

仅Expires/Last-Modified

Cache-Control/ETag/Vary

带宽优化

不支持范围请求

支持Range请求与分块传输

状态码

16种基本状态码

新增24种,如100、206、409等

内容协商

有限支持

通过Accept头与Vary灵活适配

二、面试官:不错,能不能展开聊聊HTTP长连接怎么实现的,它的优点是什么,有什么不足?

1. HTTP持久连接(长连接)的详细解析(1) 原理

HTTP持久连接(Persistent Connection),也称为长连接(Keep-Alive),允许客户端和服务器在单个TCP连接上发送和接收多个HTTP请求/响应,而无需为每个请求重新建立新的连接。

① 工作流程

HTTP/1.0:默认短连接,每个请求需建立新TCP连接,响应后立即关闭。 如需启用长连接,需显式设置头部:Connection: keep-alive。

HTTP/1.1:默认启用长连接,除非显式设置Connection: close。 客户端和服务器可复用同一TCP连接处理多个请求。

② 连接管理

保活机制:通过Keep-Alive头部字段协商参数(如超时时间、最大请求数)。 示例:Keep-Alive: timeout=5, max=100(连接空闲5秒后关闭,最多处理100个请求)。

关闭条件:

客户端/服务器发送`Connection: close`头部。 达到保活参数限制(如超时或最大请求数)。(2) 优点

① 减少TCP握手开销

每个TCP连接的建立需三次握手,关闭需四次挥手。 复用连接避免了重复握手,降低延迟(尤其对高延迟网络显著)。

② 提升资源加载效率

网页通常需加载多个资源(HTML、CSS、JS、图片等)。 长连接允许并行或串行复用同一连接,减少总加载时间。③ 减轻服务器压力

减少频繁创建/销毁连接的系统调用和内存消耗。

④ 支持管道化(Pipelining)

HTTP/1.1允许在未收到响应时发送多个请求(理论优化)。

因实现复杂和队头阻塞问题,实际使用较少,但在长连接基础上提出。

(3) 局限性

① 队头阻塞(Head-of-Line Blocking)

HTTP/1.1的串行请求:同一连接中的请求必须按顺序处理。若前一个请求处理慢(如大文件上传),后续请求被阻塞。 HTTP/2的解决方案:引入多路复用(Multiplexing),允许并行处理请求。② 资源占用问题

长连接占用服务器和客户端的TCP端口和内存资源。 高并发场景下,可能导致服务器连接数达到上限(如Linux默认ulimit -n为1024)。③ 连接空闲浪费

若连接长时间无请求,仍占用资源直到超时关闭。 需合理配置超时时间(如Nginx默认keepalive_timeout 75s)。(4) 对比不同HTTP版本

特性

HTTP/1.0

HTTP/1.1

HTTP/2

默认连接

短连接

长连接

长连接 + 多路复用

管道化支持

不支持

支持(但实际受限)

支持(并行无阻塞)

头部压缩

无

无

HPACK压缩

资源优先级

无

无

支持优先级流

2. 总结核心价值:HTTP持久连接通过复用TCP连接,显著降低延迟和服务器开销,是Web性能优化的基石。适用场景:资源密集型页面、API高频调用、高并发服务。权衡取舍:需平衡连接复用效率与资源占用,结合HTTP/2或HTTP/3进一步优化。三、面试官:刚刚你有提到HTTP的管道化(流水线)和队头阻塞,能说说看是怎么回事吗?有什么方法可以彻底解决队头阻塞问题?

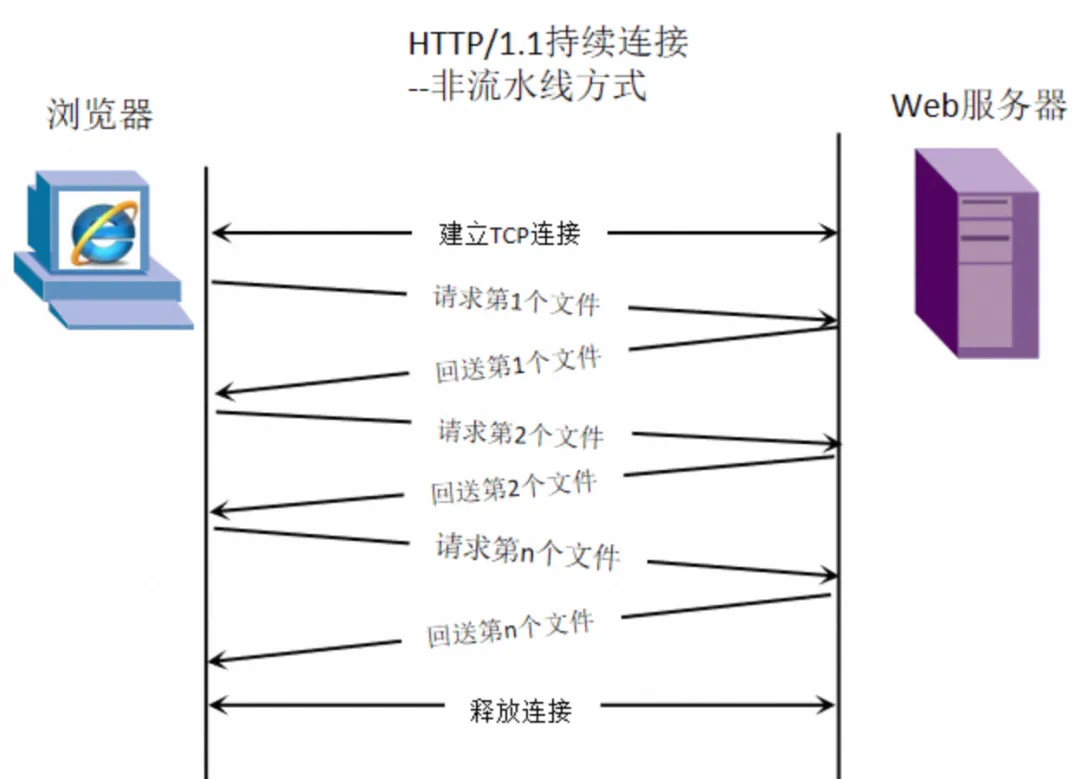

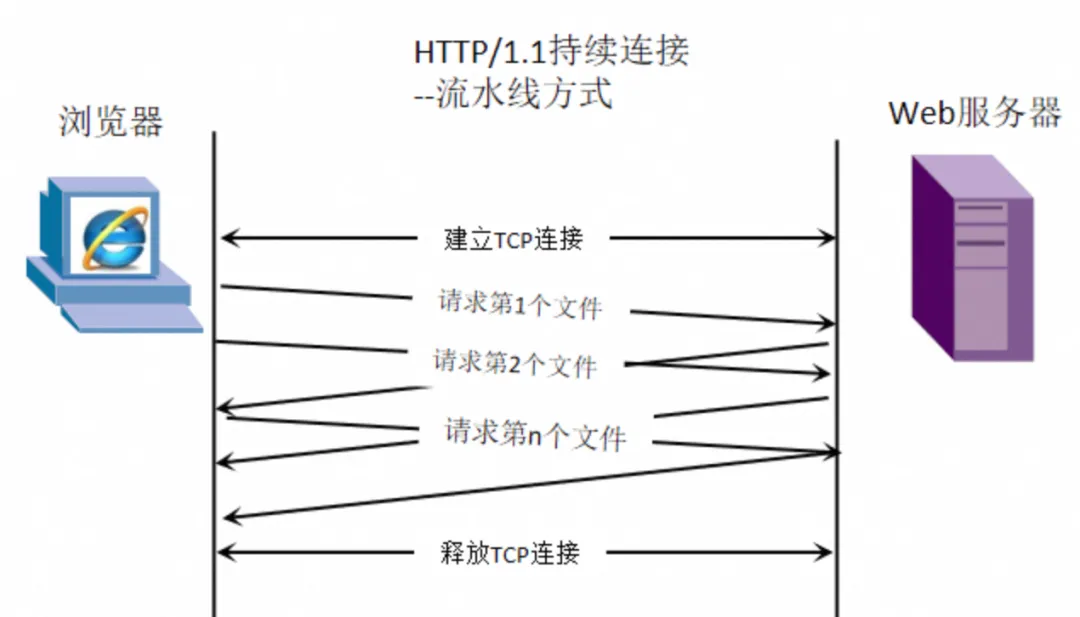

HTTP的流水线处理(HTTP Pipelining)是HTTP/1.1引入的一种优化技术,允许客户端通过同一TCP连接连续发送多个请求,而无需等待前一个请求的响应返回。

1. 流水线处理的原理(1) 与非流水线的对比

非流水线方式(如HTTP/1.0):客户端需等待前一个请求的响应完全返回后,才能发送下一个请求。例如,请求A完成后才能发送请求B,导致延迟叠加。

(2) 实现条件

依赖长连接(Persistent Connection),即通过Connection: keep-alive保持TCP连接活跃。服务器需支持按请求顺序响应,且客户端需能处理乱序到达的响应(实际中较少见,多数实现仍按顺序返回)。HTTP1.1请求报文之间没有记录请求顺序(如请求编号、序号)的信息,因此无法保证多个响应之间的返回顺序与发送的多个请求顺序相对应,也就是说发送顺序是请求1、请求2 和请求3,但由于服务端响应速度上是请求3、请求2和请求1,因此HTTP1.1依旧要等请求1的响应内容准备好之后才能依照 响应1、响应2和响应3的顺序返回。否则乱序到达的响应就可能会交付给错误的请求(如将响应3交付给了请求1)。

而上述过程中,响应3和响应2就被响应1阻塞住了,这就是所谓的队头阻塞。HTTP的队头阻塞(Head-of-Line Blocking) 是指在数据传输过程中,某个请求或数据包的延迟或丢失导致后续请求/数据被阻塞的问题。

虽然理论上HTTP1.1的流水线支持一个连接并发传输多个请求和响应,但由于队头阻塞问题无法解决,因此HTTP1.1在实际应用中不会开启流水线,依旧是一个连接只能串行传输请求和响应,要等上一个请求的响应返回了才发送下一个请求,如果要并发发送请求只能通过建立多个连接实现较为有限的并发。

队头阻塞问题在不同协议层(如HTTP/1.1、TCP)中表现不同,以下是详细说明。

2. HTTP/1.1中的队头阻塞HTTP/1.1即使启用了流水线(Pipelining),客户端可以并发的发送请求,但服务器仍需按请求顺序串行的返回响应。若第一个请求的响应因服务器处理缓慢被阻塞,后续请求即使已处理完成,也需等待前一个响应返回后才能被客户端接收。

示例:请求A、B、C依次发送,若A的响应延迟1秒,B和C的响应即使已生成,也必须在A的响应返回后才能被客户端处理。

影响 :

页面加载延迟:资源(如图片、CSS)需排队等待,拖慢整体加载速度。资源利用率低:TCP连接无法被其他请求充分利用,浪费带宽。采用HTTP2的多路复用机制可以解决应用层的队头阻塞问题。

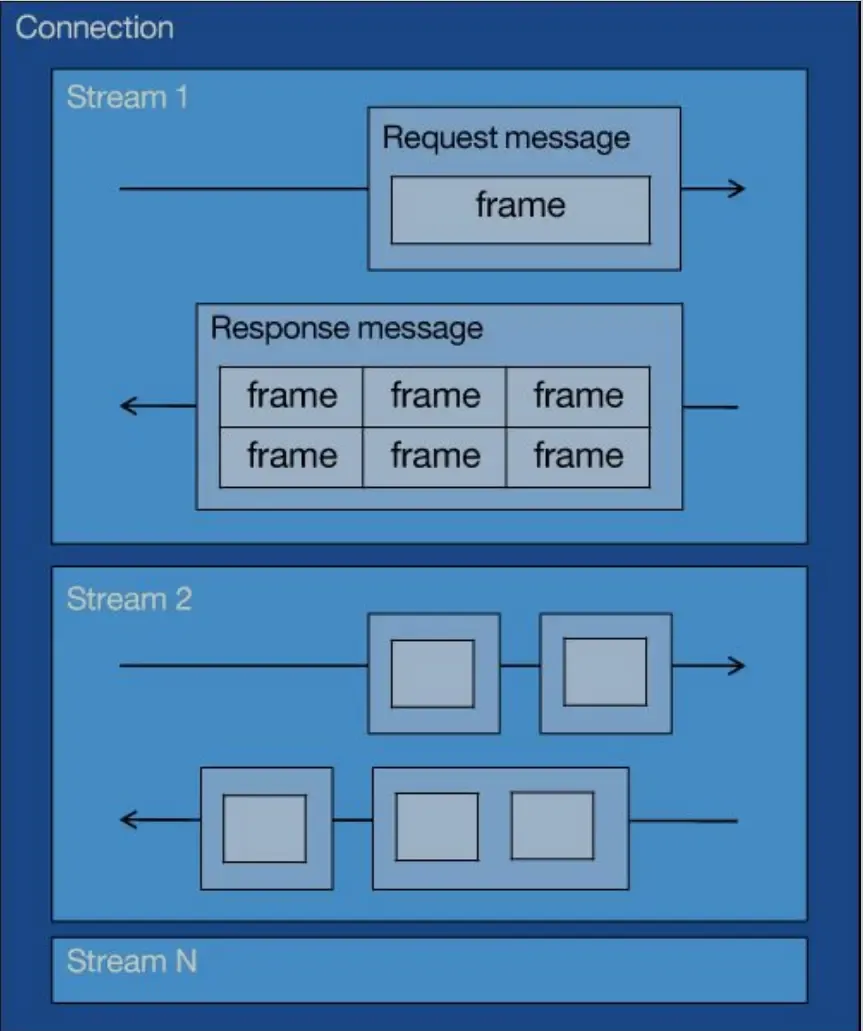

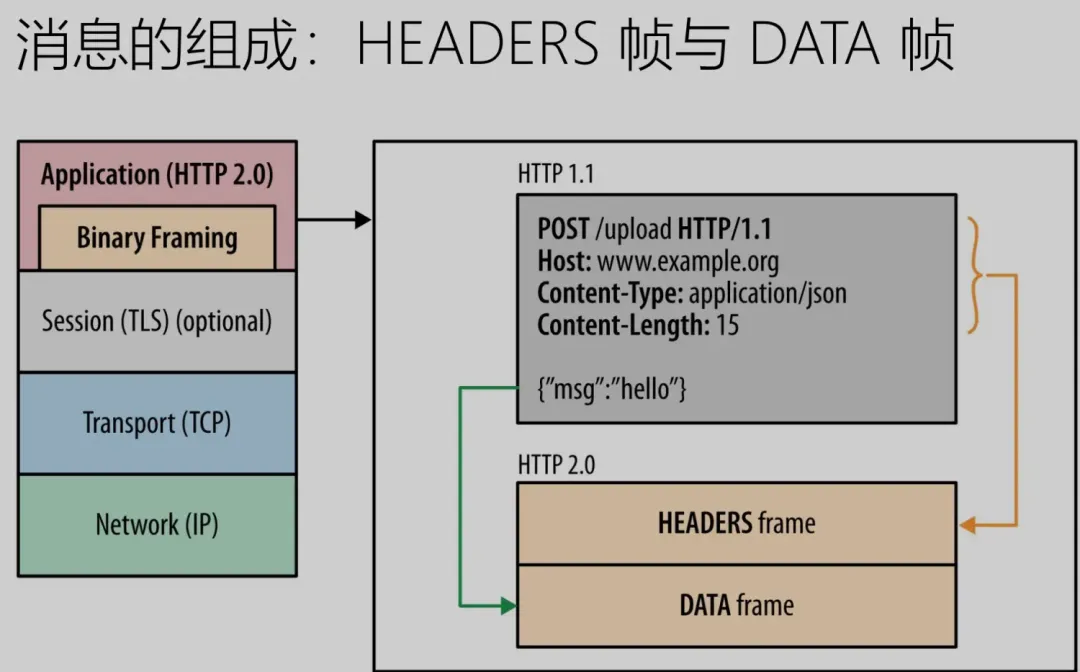

要介绍HTTP2如何解决应用层的队头阻塞,就需要介绍流(Stream)、消息(Message)和帧(Frame)的概念和他们之间的关系。

在HTTP/2中,一个流代表一个独立的请求-响应交互,可以包含多个消息,每个消息由多个帧组成。流具有唯一的标识符,可以在同一个连接上并行传输多个流的帧,从而实现多路复用。

从上图中看到:

1 个 TCP 连接包含一个或者多个 Stream;Stream 里可以包含 1 个或多个 Message,Message 对应请求或响应,由 HTTP 头部和包体构成;Message 里包含一条或者多个 Frame,Frame 是 HTTP/2 的最小传输单位,以二进制压缩格式存放请求Message;一个Message消息是由 Headers 帧和DATA 帧组成的。

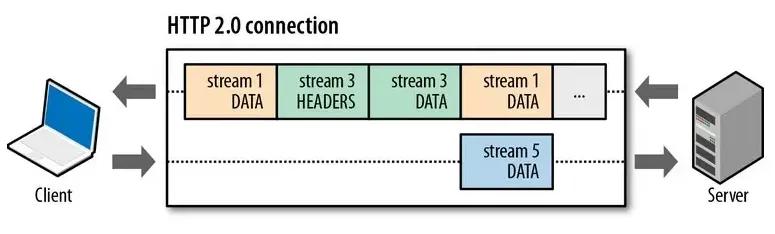

在 HTTP/2 连接上,不同 Stream 的帧是可以乱序发送的(因此可以并发不同的 Stream ),因为每个帧的头部会携带 Stream ID 信息,所以接收端可以通过 Stream ID 有序组装成 HTTP 消息,而同一 Stream 内部的帧和消息必须是严格有序的。

比如下图,服务端并行交错地发送了两个响应: Stream 1 的响应Message 和 Stream 3 的响应Message,这两个 Stream 都是跑在一个 TCP 连接上,客户端收到后,会根据相同的 Stream ID 有序组装成 HTTP 消息。

这样一来,假设stream1的请求Message比stream3的请求Message先到达服务端,而stream3的响应Message先准备好,不需要等待stream1的响应Message准备好就可以发送。客户端可以通过消息上唯一的流标识符准确的拼装好 Stream1 和 Stream3 的响应Message并通过唯一的流标识符交付给对应的请求从而解决队头阻塞问题,提高并发。

四、面试官:能不能说说看HTTP/2相比HTTP/1.1还有哪些地方做了提升?

HTTP/2 在 HTTP/1.1 的基础上通过多项技术改进显著提升了性能,主要优化点如下:

1. 多路复用HTTP/2 的多路复用(Multiplexing) 是其核心特性之一,通过在一个 TCP 连接上并行传输多个请求和响应,彻底解决了 HTTP/1.1 的队头阻塞问题。以下是其原理及性能提升的详细分析:

(1) 流(Stream)与帧(Frame)

流:HTTP/2 连接中的逻辑通道,每个流独立传输双向的帧序列(请求或响应)。帧:数据传输的最小单位,包含流标识符(Stream ID)和类型(如 HEADERS、DATA)。实现方式:多个流的帧可交错传输,客户端和服务器按流 ID 重组数据,无需按顺序等待。(2) 与 HTTP/1.1 的对比

HTTP/1.1请求/响应需严格串行化,一个请求延迟会导致后续请求阻塞(队头阻塞)。HTTP/2同一 TCP 连接上可并行处理多个请求,流之间相互独立,互不干扰。HTTP2的多路复用带来了如下提升。

① 消除队头阻塞

问题场景:在 HTTP/1.1 中,若请求 A 的响应延迟,后续请求 B、C 需排队等待。解决方案:HTTP/2 的多路复用允许请求 B、C 的帧与请求 A 的帧交错传输,即使 A 延迟,B 和 C 的响应仍可被优先处理。② 减少 TCP 连接数

HTTP/1.1:浏览器通常为每个域名建立 6-8 个 TCP 连接以并行请求资源。HTTP/2:仅需一个连接即可并行传输所有请求,降低连接建立和维护的开销(如三次握手、TLS 握手)。③ 提升传输效率

资源利用率:TCP 连接的带宽被多个流共享,避免单个请求占用TCP连接内的全部资源。延迟优化:在弱网环境下,多路复用可减少 30%-50% 的页面加载时间。例如,请求一个大 JS 文件和一个小 CSS 文件时,HTTP/2 可并行传输,而 HTTP/1.1 需串行等待。④ 节省服务器资源

减少并发连接数可降低服务器内存和 CPU 的消耗,提升高负载场景下的稳定性。

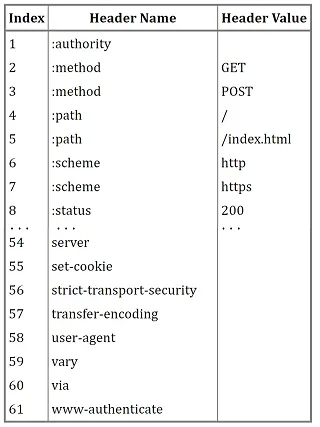

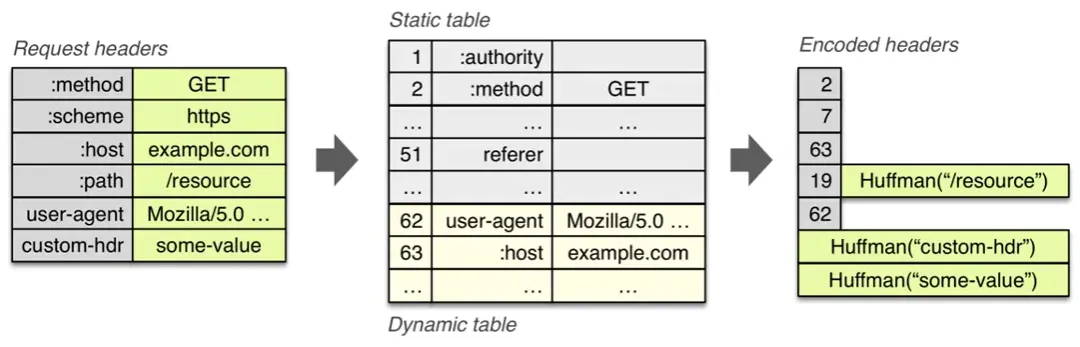

2. 头部压缩HTTP/2 的头部压缩是通过 HPACK 算法实现的核心优化技术,旨在减少 HTTP 头部的冗余数据,提升传输效率。以下是其原理及优点的详细说明:

(1) HPACK 算法

核心思想:通过静态表、动态表和哈夫曼编码,消除重复的头部字段,减少传输体积。

实现方式:

静态表(Static Table):预定义 61 个常用头部字段(如 `:method`、`:path`、`content-type`),直接用索引号代替完整字段名。例如,`:method: GET` 可编码为索引 `2`,仅需传输 1 字节。

例如,首次发送 `user-agent: Mozilla/5.0` 后,后续请求只需发送其动态表索引。

哈夫曼编码(Huffman Coding):对头部字段的键和值进行字符级压缩,高频字符用短编码,低频字符用长编码。例如,字母 `e` 出现频率高,编码为 `010`,而 `z` 编码为 `111111`。头部压缩的总和效果如下图所示:

(2) 头部压缩的优点

① 显著减少带宽消耗

通过消除冗余头部字段(如重复的 Cookie、User-Agent),降低传输数据量,尤其适用于移动端或低带宽环境。例如,一个包含 20 个请求的页面,HTTP/1.1 的头部总大小可能达 10KB,而 HTTP/2 压缩后可降至 1KB 以下。② 降低延迟,提升并发性能

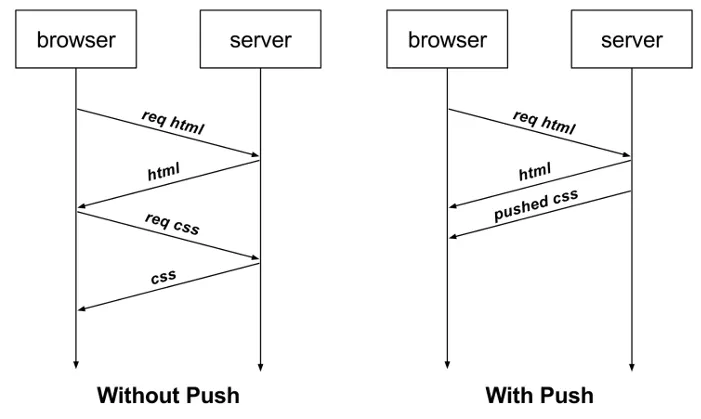

减少 TCP 连接数:头部压缩允许单个连接承载更多请求。加速首屏加载:关键资源(如 HTML、CSS)的头部压缩后,传输时间缩短,页面渲染更快。3. 服务器推送HTTP/2 的服务器推送(Server Push) 是一种允许服务器主动向客户端发送资源的技术,无需等待客户端显式请求。以下是其特性与优点的详细说明:

(1) 主动推送机制

服务器在客户端请求一个资源(如 HTML 页面)时,可主动推送与之关联的其他资源(如 CSS、JS、图片)。

示例:客户端请求 index.html,服务器同时推送 style.css 和 script.js,减少后续请求的往返时间(RTT)。

(2) 资源预判与优先级

服务器可根据业务逻辑预判客户端需要的资源(如通过 Link 头部声明推送列表)。支持设置推送资源的优先级,确保关键资源(如首屏 CSS)优先传输。(3) 服务器推送的优点与局限性

① 显著减少延迟(优点)

减少往返次数:通过提前推送资源,客户端无需额外发起请求,降低页面加载时间。加速首屏渲染:关键资源(如 CSS、JS)的提前到达可更快完成页面渲染。② 仅支持静态资源(局限)

服务器推送无法传输动态生成的内容(如实时数据),需结合 WebSocket 或 SSE 实现实时通信。

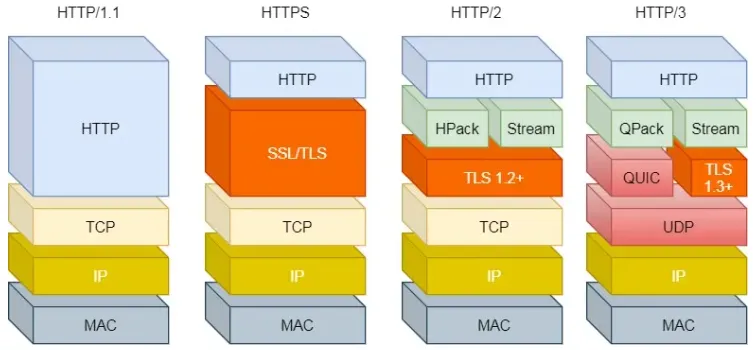

4. 安全机制提升协议要求:HTTP/2 规范(RFC 7540)建议与 TLS 1.2 或更高版本 结合使用,且必须支持 前向安全(Forward Secrecy) 和 服务器名称指示(SNI)。TLS 1.3 支持:HTTP/2 结合 TLS 1.3 时,握手仅需 1 个往返时间(RTT),且通过临时密钥(Ephemeral Key)实现前向安全,即使长期密钥泄露,历史通信也无法被解密。会话复用:支持基于会话 ID 或票据(Session Ticket)的快速握手,减少重复连接的加密开销。二进制分帧:HTTP/2 使用二进制格式而非明文传输,降低中间设备(如代理、防火墙)因解析文本协议导致的注入攻击或篡改风险。头部压缩安全:HPACK 算法通过动态表和哈夫曼编码压缩头部,避免明文头部字段被窃取或篡改。五、面试官:HTTP/2有什么局限性?HTTP/3基于UPD的QUIC协议如何提升连接效率??

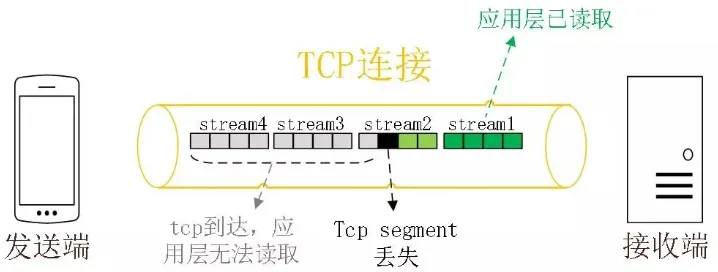

1. HTTP/2 的缺陷(1) TCP层面的队头阻塞

HTTP/2 通过 Stream 的并发能力,解决了 HTTP/1 队头阻塞的问题,看似很完美了,但是 HTTP/2 还是存在“队头阻塞”的问题,只不过问题不是在 HTTP 这一层面,而是在 TCP 这一层。

HTTP/2 是基于 TCP 协议来传输数据的,TCP 是字节流协议,TCP 层必须保证收到的字节数据是完整且连续的,这样内核才会将缓冲区里的数据返回给 HTTP 应用,那么当「前 1 个字节数据」没有到达时,后收到的字节数据只能存放在内核缓冲区里,只有等到这 1 个字节数据到达时,HTTP/2 应用层才能从内核中拿到数据,这就是 HTTP/2 队头阻塞问题。

图片

图片

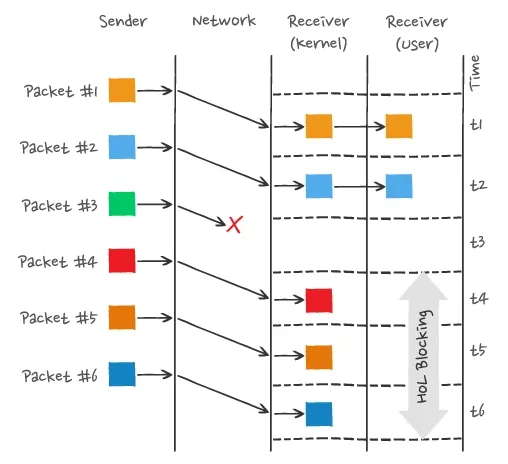

因为 TCP 是字节流协议,TCP 层必须保证收到的字节数据是完整且有序的,如果序列号较低的 TCP 段在网络传输中丢失了,即使序列号较高的 TCP 段已经被接收了,应用层也无法从内核中读取到这部分数据。从 HTTP 视角看,就是请求被阻塞了。

举个例子,如下图:

图中发送方发送了很多个 Packet,每个 Packet 都有自己的序号,你可以认为是 TCP 的序列号,其中 Packet 3 在网络中丢失了,即使 Packet 4~6 被接收方收到后,由于内核中的 TCP 数据不是连续的,于是接收方的应用层就无法从内核中读取到,只有等到 Packet 3 重传后,接收方的应用层才可以从内核中读取到数据,这就是 HTTP/2 的队头阻塞问题,是在 TCP 层面发生的。

所以,一旦发生了丢包现象,就会触发 TCP 的重传机制,这样在一个 TCP 连接中的所有的 HTTP 请求都必须等待这个丢了的包被重传回来。

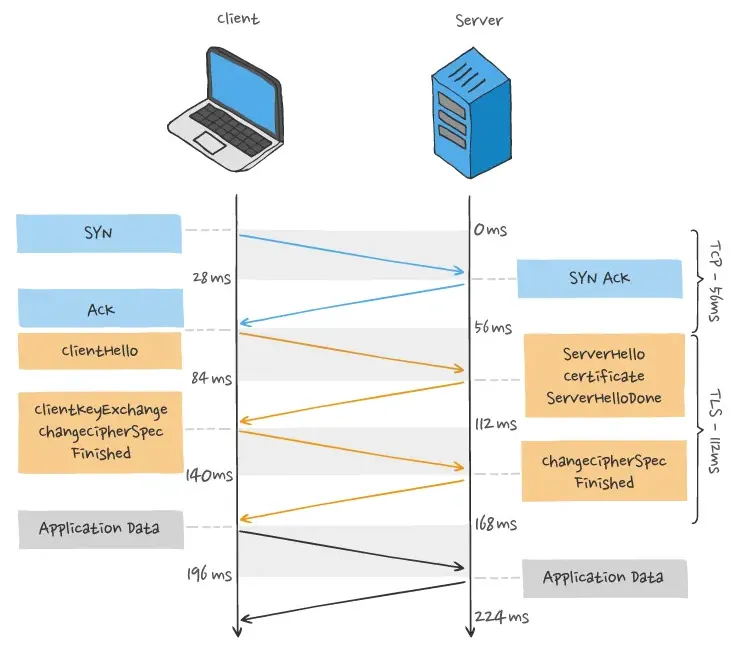

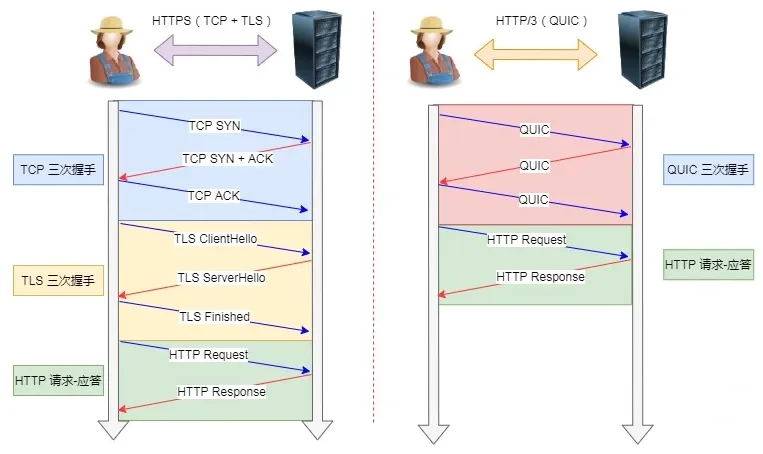

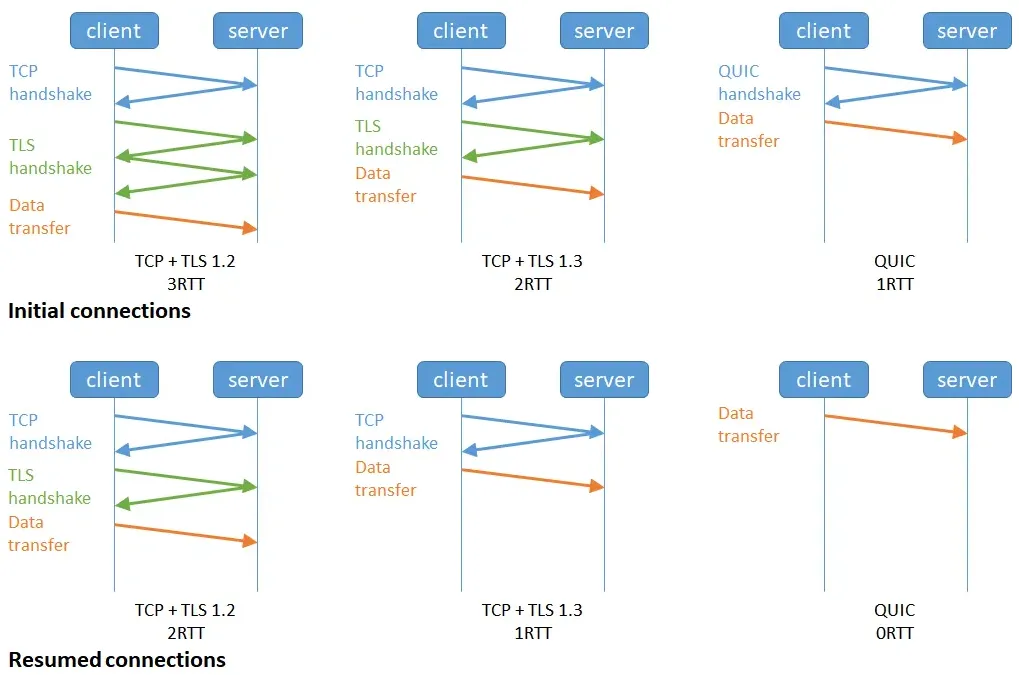

(2) TCP 与 TLS 的握手时延迟

发起 HTTP 请求时,需要经过 TCP 三次握手和 TLS 四次握手(TLS 1.2)的过程,因此共需要 3 个 RTT 的时延才能发出请求数据。

另外,TCP 由于具有「拥塞控制」的特性,所以刚建立连接的 TCP 会有个「慢启动」的过程,它会对 TCP 连接产生“减速”效果。

(3) 网络迁移需要重新连接

一个 TCP 连接是由四元组(源 IP 地址,源端口,目标 IP 地址,目标端口)确定的,这意味着如果 IP 地址或者端口变动了,就会导致需要 TCP 与 TLS 重新握手,这不利于移动设备切换网络的场景,比如 4G 网络环境切换成 WiFi。

这些问题都是 TCP 协议固有的问题,无论应用层的 HTTP/2 在怎么设计都无法避免。

HTTP3把传输层协议替换成 UDP,从传输层彻底进行优化。

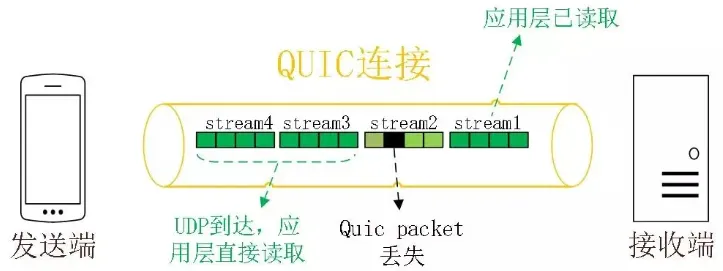

(1) 无队头阻塞

QUIC 协议也有类似 HTTP/2 Stream 与多路复用的概念,也是可以在同一条连接上并发传输多个 Stream,Stream 可以认为就是一条 HTTP 请求。

由于 QUIC 使用的传输协议是 UDP,UDP 不关心数据包的顺序,如果数据包丢失,UDP 也不关心。

不过 QUIC 协议会保证数据包的可靠性,每个数据包都有一个序号唯一标识。当某个流中的一个数据包丢失了,即使该流的其他数据包到达了,数据也无法被 HTTP/3 读取,直到 QUIC 重传丢失的报文,数据才会交给 HTTP/3。

而其他流的数据报文只要被完整接收,HTTP/3 就可以读取到数据。可以认为HTTP/3 把 HTTP/2 在应用层上的多个流的概念转移到了传输层上,解决了传输层的队头阻塞问题。

(2) 更快的连接建立

对于 HTTP/1 和 HTTP/2 协议,TCP 和 TLS 是分层的,分别属于内核实现的传输层、OpenSSL 库实现的表示层,因此它们难以合并在一起,需要分批次来握手,先 TCP 握手,再 TLS 握手。

HTTP/3 在传输数据前虽然需要 QUIC 协议握手,这个握手过程只需要 1 RTT,握手的目的是为确认双方的「连接 ID」,连接迁移就是基于连接 ID 实现的。

但是 HTTP/3 的 QUIC 协议并不是与 TLS 分层,而是 QUIC 内部包含了 TLS,它在自己的帧会携带 TLS 里的“记录”,再加上 QUIC 使用的是 TLS/1.3,因此仅需 1 个 RTT 就可以「同时」完成建立连接与密钥协商,如下图:

甚至,在第二次连接的时候,应用数据包可以和 QUIC 握手信息(连接信息 + TLS 信息)一起发送,达到 0-RTT 的效果。

如下图右边部分,HTTP/3 当会话恢复时,有效负载数据与第一个数据包一起发送,可以做到 0-RTT(下图的右下角):

(3) 连接迁移

基于 TCP 传输协议的 HTTP 协议,由于是通过四元组(源 IP、源端口、目的 IP、目的端口)确定一条 TCP 连接。

那么当移动设备的网络从 4G 切换到 WIFI 时,意味着 IP 地址变化了,那么就必须要断开连接,然后重新建立连接。而建立连接的过程包含 TCP 三次握手和 TLS 四次握手的时延,以及 TCP 慢启动的减速过程,给用户的感觉就是网络突然卡顿了一下,因此连接的迁移成本是很高的。

而 QUIC 协议没有用四元组的方式来“绑定”连接,而是通过连接 ID 来标记通信的两个端点,客户端和服务器可以各自选择一组 ID 来标记自己,因此即使移动设备的网络变化后,导致 IP 地址变化了,只要仍保有上下文信息(比如连接 ID、TLS 密钥等),就可以“无缝”地复用原连接,消除重连的成本,没有丝毫卡顿感,达到了连接迁移的功能。