内核视角看Epoll LT/ET:数据结构与回调机制全解

在Linux网络编程领域,Epoll 堪称一颗璀璨明星,凭借其卓越性能,在高并发场景中大放异彩。想深度洞察 Epoll 的高效运作奥秘,从内核视角剖析其数据结构与回调机制是不二之选。Epoll 有水平触发(LT)和边缘触发(ET)两种模式,二者在事件通知时机与处理方式上大相径庭,这也使得它们适用于不同的应用场景。而内核中的数据结构,如红黑树、就绪链表等,宛如精密齿轮,协同运作,支撑着 Epoll 精准且高效地管理大量文件描述符。

同时,回调机制则如同灵动纽带,将内核与用户空间紧密相连,确保事件能够及时、准确地传递,让应用程序迅速做出响应。接下来,让我们一同踏入内核的奇妙世界,抽丝剥茧,深入探究 Epoll LT 和 ET 模式下的数据结构精妙设计与回调机制的运作逻辑,解锁 Epoll 高效性能背后的神秘密码 。

Part1Epoll核心工作原理

1.1 Epoll 是什么Epoll是Linux下多路复用IO接口select/poll的增强版本 ,诞生于 Linux 2.6 内核。它能显著提高程序在大量并发连接中只有少量活跃的情况下的系统 CPU 利用率。在传统的 select/poll 模型中,当需要处理大量的文件描述符时,每次调用都需要线性扫描全部的集合,导致效率随着文件描述符数量的增加而呈现线性下降。

而 Epoll 采用了事件驱动机制,内核会将活跃的文件描述符主动通知给应用程序,应用程序只需处理这些活跃的文件描述符即可,大大减少了无效的扫描操作。这就好比在一个大型图书馆中,select/poll 需要逐本书籍去查找是否有读者需要借阅,而 Epoll 则是当有读者需要借阅某本书时,图书馆管理员主动将这本书找出来交给读者,效率高下立判。

在 I/O 多路复用机制中,select 和 poll 是 epoll 的 “前辈”,但它们存在一些明显的不足,而 epoll 正是为克服这些不足而出现的。

select 是最早被广泛使用的 I/O 多路复用函数,它允许一个进程监视多个文件描述符。然而,select 存在一个硬伤,即单个进程可监视的文件描述符数量被限制在 FD_SETSIZE(通常为 1024),这在高并发场景下远远不够。例如,一个大型的在线游戏服务器,可能需要同时处理成千上万的玩家连接,select 的这个限制就成为了性能瓶颈。此外,select 每次调用时,都需要将所有文件描述符从用户空间拷贝到内核空间,检查完后再拷贝回用户空间,并且返回后需要通过遍历 fd_set 来找到就绪的文件描述符,时间复杂度为 O (n)。当文件描述符数量较多时,这种无差别轮询会导致效率急剧下降,大量的 CPU 时间浪费在遍历操作上。

poll 在一定程度上改进了 select 的不足,它没有了文件描述符数量的硬限制,使用 pollfd 结构体数组来表示文件描述符集合,并且将监听事件和返回事件分开,简化了编程操作。但 poll 本质上和 select 没有太大差别,它同样需要将用户传入的数组拷贝到内核空间,然后查询每个 fd 对应的设备状态。在处理大量文件描述符时,poll 每次调用仍需遍历整个文件描述符数组,时间复杂度依然为 O (n),随着文件描述符数量的增加,性能也会显著下降。而且,poll 在用户态与内核态之间的数据拷贝开销也不容忽视。

epoll 则在设计上有了质的飞跃。它没有文件描述符数量的上限,能轻松处理成千上万的并发连接,这使得它非常适合高并发的网络应用场景。epoll 采用事件驱动模式,通过 epoll_ctl 函数将文件描述符和感兴趣的事件注册到内核的事件表中,内核使用红黑树来管理这些文件描述符,保证了插入、删除和查找的高效性。当有事件发生时,内核会将就绪的文件描述符加入到就绪链表中,应用程序通过 epoll_wait 函数获取这些就绪的文件描述符,只需处理有状态变化的文件描述符即可,避免了遍历所有文件描述符的开销,时间复杂度为 O (1)。这种高效的机制使得 epoll 在高并发情况下能够保持良好的性能,大大提升了系统的吞吐量和响应速度 。

1.2 Epoll 的核心接口Epoll 提供了三个核心接口,它们是 Epoll 机制的关键所在,就像三把钥匙,开启了高效 I/O 处理的大门。下面我们详细介绍这三个系统调用的功能、参数和返回值,并结合代码示例展示它们的使用方法。

(1)epoll_create

epoll_create用于创建一个 epoll 实例,返回一个文件描述符,后续对 epoll 的操作都将通过这个文件描述符进行。在 Linux 2.6.8 之后,size参数被忽略,但仍需传入一个大于 0 的值。epoll_create1是epoll_create的增强版本,flags参数可以设置为 0,功能与epoll_create相同;也可以设置为EPOLL_CLOEXEC,表示在执行exec系列函数时自动关闭该文件描述符。

例如:

上述代码创建了一个 epoll 实例,并检查创建是否成功。如果返回值为 - 1,说明创建失败,通过perror打印错误信息。

(2)epoll_ctl

epoll_ctl用于控制 epoll 实例,对指定的文件描述符fd执行操作op。epfd是epoll_create返回的 epoll 实例文件描述符;op有三个取值:EPOLL_CTL_ADD表示将文件描述符fd添加到 epoll 实例中,并监听event指定的事件;EPOLL_CTL_MOD用于修改已添加的文件描述符fd的监听事件;EPOLL_CTL_DEL则是将文件描述符fd从 epoll 实例中删除,此时event参数可以为 NULL。

event是一个指向epoll_event结构体的指针,该结构体定义如下:

events字段表示要监听的事件类型,常见的有EPOLLIN(表示对应的文件描述符可以读)、EPOLLOUT(表示对应的文件描述符可以写)、EPOLLRDHUP(表示套接字的一端已经关闭,或者半关闭)、EPOLLERR(表示对应的文件描述符发生错误)、EPOLLHUP(表示对应的文件描述符被挂起)等。data字段是一个联合体,可用于存储用户自定义的数据,通常会将fd存储在这里,以便在事件触发时识别是哪个文件描述符。

例如,将标准输入(STDIN_FILENO)添加到 epoll 实例中,监听可读事件:

上述代码将标准输入的文件描述符添加到 epoll 实例中,监听可读事件EPOLLIN。如果epoll_ctl调用失败,打印错误信息并关闭 epoll 实例。

(3)epoll_wait

epoll_wait用于等待 epoll 实例上的事件发生。epfd是 epoll 实例的文件描述符;events是一个指向epoll_event结构体数组的指针,用于存储发生的事件;maxevents表示events数组最多能容纳的事件数量;timeout是超时时间,单位为毫秒。如果timeout为 - 1,表示无限期等待,直到有事件发生;如果为 0,则立即返回,不等待任何事件;如果为正数,则等待指定的毫秒数,超时后返回。

返回值为发生的事件数量,如果返回 0 表示超时且没有事件发生;如果返回 - 1,表示发生错误,可通过errno获取具体错误信息。

例如:

上述代码使用epoll_wait等待 epoll 实例上的事件发生,最多等待 10 个事件,无限期等待。当有事件发生时,遍历events数组,检查是否是标准输入的可读事件。如果是,读取标准输入的数据并打印读取的字节数。

通过这三个系统调用,我们可以创建 epoll 实例,注册文件描述符及其感兴趣的事件,然后等待事件发生并处理,实现高效的 I/O 多路复用。

1.3 Epoll 的底层数据结构epoll之所以性能卓越,离不开其精心设计的数据结构。epoll主要依赖红黑树和双向链表这两种数据结构来实现高效的事件管理,再配合三个核心API,让它在处理大量并发连接时游刃有余 。

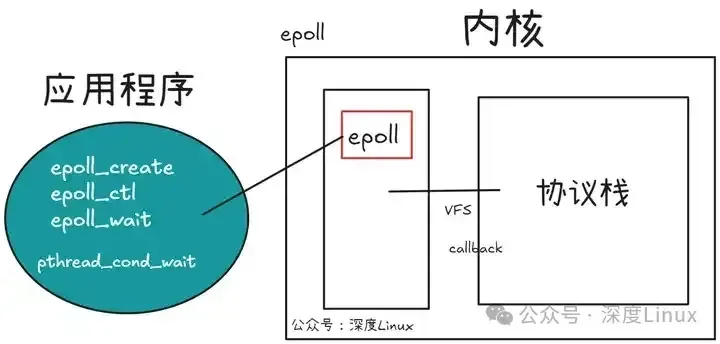

epoll工作在应用程序和内核协议栈之间。epoll是在内核协议栈和vfs都有的情况下才有的。

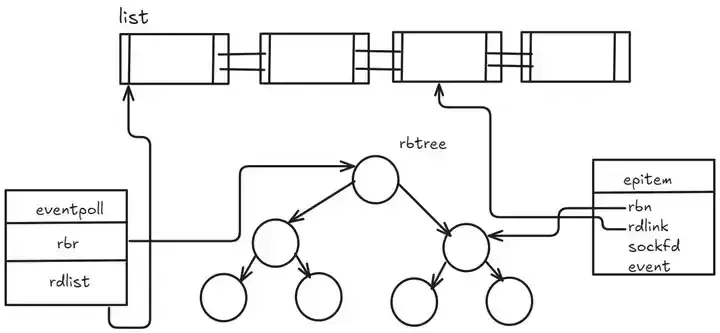

epoll 的核心数据结构是:1个红黑树和1个双向链表。还有3个核心API。

可以看到,链表和红黑树使用的是同一个结点。实际上是红黑树管理所有的IO,当内部IO就绪的时候就会调用epoll的回调函数,将相应的IO添加到就绪链表上。数据结构有epitm和eventpoll,分别代表红黑树和单个结点,在单个结点上分别使用rbn和rblink使得结点同时指向两个数据结构。

(1)红黑树的巧妙运用

epoll 使用红黑树来管理所有注册的文件描述符。红黑树是一种自平衡的二叉搜索树,它有着非常优秀的性质:每个节点要么是红色,要么是黑色;根节点是黑色;所有叶子节点(通常是 NULL 节点)是黑色;如果一个节点是红色,那么它的两个子节点都是黑色;从任一节点到其每个叶子的所有路径都包含相同数目的黑色节点 。这些性质保证了红黑树的高度近似平衡,使得查找、插入和删除操作的时间复杂度都稳定在 O (log n),这里的 n 是红黑树中节点的数量。

因为链表在查询,删除的时候毫无疑问时间复杂度是O(n);数组查询很快,但是删除和新增时间复杂度是O(n);二叉搜索树虽然查询效率是lgn,但是如果不是平衡的,那么就会退化为线性查找,复杂度直接来到O(n);B+树是平衡多路查找树,主要是通过降低树的高度来存储上亿级别的数据,但是它的应用场景是内存放不下的时候能够用最少的IO访问次数从磁盘获取数据。比如数据库聚簇索引,成百上千万的数据内存无法满足查找就需要到内存查找,而因为B+树层高很低,只需要几次磁盘IO就能获取数据到内存,所以在这种磁盘到内存访问上B+树更适合。因为我们处理上万级的fd,它们本身的存储空间并不会很大,所以倾向于在内存中去实现管理,而红黑树是一种非常优秀的平衡树,它完全是在内存中操作,而且查找,删除和新增时间复杂度都是lgn,效率非常高,因此选择用红黑树实现epoll是最佳的选择。

当然不选择用AVL树是因为红黑树是不符合AVL树的平衡条件的,红黑树用非严格的平衡来换取增删节点时候旋转次数的降低,任何不平衡都会在三次旋转之内解决;而AVL树是严格平衡树,在增加或者删除节点的时候,根据不同情况,旋转的次数比红黑树要多。所以红黑树的插入效率更高。

我们来具体分析一下。假如我们有一个服务器,需要监听 1000 个客户端的连接,每个连接对应一个文件描述符。如果使用普通的链表来管理这些文件描述符,当我们要查找某个特定的文件描述符时,最坏情况下需要遍历整个链表,时间复杂度是 O (n),也就是需要 1000 次比较操作。但如果使用红黑树,由于其平衡特性,即使在最坏情况下,查找一个文件描述符也只需要 O (log n) 次比较操作,对于 1000 个节点的红黑树,log₂1000 约等于 10 次左右,相比链表效率大大提高。同样,在插入新的文件描述符(比如有新的客户端连接)和删除文件描述符(比如客户端断开连接)时,红黑树的 O (log n) 时间复杂度也比链表的 O (n) 高效得多。

再对比一下其他数据结构。数组虽然查询效率高,时间复杂度为 O (1),但插入和删除操作比较麻烦,平均时间复杂度为 O (n) 。二叉搜索树在理想情况下查找、插入和删除的时间复杂度是 O (log n),但如果树的平衡性被破坏,比如节点插入顺序不当,就可能退化为链表,时间复杂度变成 O (n)。

B + 树主要用于磁盘存储,适合处理大量数据且需要频繁磁盘 I/O 的场景,在内存中管理文件描述符不如红黑树高效。所以,综合考虑,红黑树是 epoll 管理大量文件描述符的最佳选择,它能够快速地定位和操作文件描述符,大大提高了 epoll 的性能。

(2)就绪socket列表-双向链表

除了红黑树,epoll 还使用双向链表来存储就绪的 socket。当某个文件描述符上有事件发生(比如有数据可读、可写),对应的 socket 就会被加入到这个双向链表中。双向链表的优势在于它可以快速地插入和删除节点,时间复杂度都是 O (1) 。这对于 epoll 来说非常重要,因为在高并发场景下,就绪的 socket 可能随时增加或减少。

就绪列表存储的是就绪的socket,所以它应能够快速的插入数据;程序可能随时调用epoll_ctl添加监视socket,也可能随时删除。当删除时,若该socket已经存放在就绪列表中,它也应该被移除。(事实上,每个epoll_item既是红黑树节点,也是链表节点,删除红黑树节点,自然删除了链表节点)所以就绪列表应是一种能够快速插入和删除的数据结构。双向链表就是这样一种数据结构,epoll使用双向链表来实现就绪队列(rdllist)。

想象一下,在一个繁忙的在线游戏服务器中,同时有大量玩家在线。每个玩家的连接都由一个 socket 表示,当某个玩家发送了操作指令(比如移动、攻击等),对应的 socket 就有数据可读,需要被加入到就绪列表中等待服务器处理。如果使用单向链表,插入节点时虽然也能实现,但删除节点时,由于单向链表只能从前往后遍历,找到要删除节点的前驱节点比较麻烦,时间复杂度会达到 O (n) 。而双向链表每个节点都有指向前驱和后继节点的指针,无论是插入还是删除节点,都可以在 O (1) 时间内完成。当服务器处理完某个 socket 的事件后,如果该 socket 不再有就绪事件,就可以快速地从双向链表中删除,不会影响其他节点的操作。

双向链表和红黑树在 epoll 中协同工作。红黑树负责管理所有注册的文件描述符,保证文件描述符的增删查操作高效进行;而双向链表则专注于存储就绪的 socket,让应用程序能够快速获取到有事件发生的 socket 并进行处理。当一个 socket 的事件发生时,epoll 会先在红黑树中找到对应的节点,然后将其加入到双向链表中。这样,epoll_wait 函数只需要遍历双向链表,就能获取到所有就绪的 socket,避免了对大量未就绪 socket 的无效遍历,大大提高了事件处理的效率。

(3)红黑树和就绪队列的关系

红黑树的结点和就绪队列的结点的同一个节点,所谓的加入就绪队列,就是将结点的前后指针联系到一起。所以就绪了不是将红黑树结点delete掉然后加入队列。他们是同一个结点,不需要delete。

Epoll 还利用了mmap机制来减少内核态和用户态之间的数据拷贝。在传统的I/O模型中,内核将数据从内核缓冲区拷贝到用户缓冲区时,需要进行两次数据拷贝,而Epoll通过mmap将内核空间和用户空间的一块内存映射到相同的物理地址,使得内核可以直接将数据写入用户空间的内存,减少了一次数据拷贝,提高了数据传输的效率 。

Part2LT与ET模式详解

2.1 LT(水平触发)模式(1)触发原理:LT 模式就像是一个勤劳且执着的快递小哥,当被监控的文件描述符上有可读写事件发生时,epoll_wait 就会像收到通知的小哥一样,立刻通知处理程序去读写。而且,如果一次没处理完,下次调用 epoll_wait 它还会继续通知,就如同小哥发现你没取走快递,会反复提醒你一样 。这是因为在 LT 模式下,只要文件描述符对应的缓冲区中还有未处理的数据,或者缓冲区还有可写入的空间,对应的事件就会一直被触发。

(2)实际表现:以网络通信中的数据接收为例,当一个 socket 接收到数据时,内核会将数据放入接收缓冲区。在 LT 模式下,只要接收缓冲区中有数据,每次调用 epoll_wait 都会返回该 socket 的可读事件,通知应用程序去读取数据。哪怕应用程序只读取了部分数据,下次 epoll_wait 依然会返回该 socket 的可读事件,直到接收缓冲区中的数据被全部读完 。下面是一段简单的代码示例,展示了 LT 模式下数据读取的过程:

在这段代码中,当有新的连接到来时,将新连接的 socket 添加到 epoll 实例中。对于已连接的 socket,在 LT 模式下,只要有数据可读,recv 函数就会被调用读取数据,即使一次没有读完,下次 epoll_wait 依然会触发可读事件 。

2.2 ET(边缘触发)模式(1)触发原理:ET 模式则像是一个 “高冷” 的快递小哥,只有当被监控的文件描述符上的事件状态发生变化,即从无到有时才会触发通知,而且只通知一次 。在 ET 模式下,对于读事件,只有当 socket 的接收缓冲区由空变为非空时才会触发;对于写事件,只有当 socket 的发送缓冲区由满变为非满时才会触发 。这就要求应用程序在接收到 ET 模式的通知后,必须尽可能地一次性处理完所有相关数据,因为后续不会再收到重复的通知。

(2)实际表现:在实际应用中,ET 模式下的数据读取需要特别注意。由于只通知一次,所以通常需要循环读取数据,直到返回 EAGAIN 错误,表示缓冲区中已经没有数据可读了 。以 socket 接收数据为例,代码示例如下:

在这个示例中,首先将新连接的 socket 设置为非阻塞模式,然后以 ET 模式添加到 epoll 实例中。在处理读事件时,通过循环调用 recv 函数,直到返回 EAGAIN 错误,确保将缓冲区中的数据全部读取出来 。

2.3 LT 与 ET 的对比触发次数:从触发次数上看,LT 模式会多次触发事件,直到相关缓冲区中的数据处理完毕或者可写空间被充分利用;而 ET 模式仅在事件状态发生变化时触发一次,后续不会再因相同事件而触发 。这就像两个快递小哥,一个会反复通知你取快递,直到你取走;另一个只通知你一次,取不取随你。数据处理方式:在数据处理方式上,LT 模式相对简单,应用程序可以根据自己的节奏逐步处理数据,每次 epoll_wait 返回后处理一部分数据即可;而 ET 模式要求应用程序更加 “激进”,一旦接收到事件通知,就需要尽可能一次性将缓冲区中的数据全部处理完,否则可能会丢失数据 。例如,在处理大量网络数据包时,LT 模式可以每次读取少量数据,慢慢处理;而 ET 模式则需要在一次事件通知中读取完所有到达的数据包。效率:从效率角度来说,ET 模式在处理大量并发连接且每个连接数据量较小的场景下具有更高的效率,因为它减少了不必要的事件触发,降低了系统开销;而 LT 模式虽然在某些情况下可能会产生一些冗余的触发,但它的编程复杂度较低,更易于理解和实现,在一些对效率要求不是特别苛刻的场景中也能发挥很好的作用 。例如,在一个高并发的 Web 服务器中,如果每个请求的数据量较小,ET 模式可以更高效地处理请求;而在一个对稳定性和开发效率要求较高的小型应用中,LT 模式可能是更好的选择 。Part3回调机制详解

epoll 的回调机制是其高效的关键所在 。当一个文件描述符(比如 socket)就绪时(即有数据可读、可写或者发生错误等事件),内核会调用预先注册的回调函数 。这个回调函数的主要任务是将就绪的socket放入 epoll 的就绪链表中,然后唤醒正在等待的应用程序(通过 epoll_wait 阻塞的应用程序线程)。

3.1 回调函数的作用在 Epoll 的世界里,回调函数就像是一个隐藏在幕后的 “幕后英雄”,默默地发挥着关键作用。具体来说,ep_poll_callback 回调函数在内核中扮演着将事件添加到就绪链表 rdllist 的重要角色 。当被监听的文件描述符上发生了对应的事件(如可读、可写等),内核就会调用 ep_poll_callback 函数。这个函数就像是一个 “快递分拣员”,将发生事件的文件描述符及其对应的事件信息,准确无误地添加到就绪链表 rdllist 中 。

这样,当应用程序调用 epoll_wait 时,就可以直接从就绪链表中获取到这些就绪的事件,而无需再去遍历整个红黑树,大大提高了事件获取的效率 。例如,在一个网络服务器中,当有新的数据到达某个 socket 时,内核会调用 ep_poll_callback 将该 socket 的可读事件添加到就绪链表,服务器程序通过 epoll_wait 就能及时获取到这个事件,从而进行数据读取和处理 。

3.2 回调机制的工作流程回调机制的工作流程是一个环环相扣的精密过程,从事件发生到最终被应用程序处理,每一步都紧密相连。当一个文件描述符上发生了感兴趣的事件,比如一个 socket 接收到了数据 。内核中的设备驱动程序会首先感知到这个事件。由于在调用 epoll_ctl 添加文件描述符时,已经为该文件描述符注册了 ep_poll_callback 回调函数,所以设备驱动程序会调用这个回调函数 。ep_poll_callback 函数被调用后,会将包含该文件描述符和事件信息的 epitem 结构体添加到 eventpoll 结构体的就绪链表 rdllist 中 。这就好比将一封封 “快递”(事件)放到了一个专门的 “收件箱”(就绪链表)里。

当应用程序调用 epoll_wait 时,它会检查就绪链表 rdllist 是否有数据。如果有,就将链表中的事件复制到用户空间的 epoll_event 数组中,并返回事件的数量 。应用程序根据返回的事件,对相应的文件描述符进行处理,比如读取 socket 中的数据 。下面是一个简化的代码示例,来展示这个过程:

在这个示例中,epoll_wait 从就绪链表中获取到就绪事件,应用程序通过遍历 events 数组,对发生读事件的文件描述符进行数据读取操作 。

Part4应用场景与选择策略

4.1 LT模式的适用场景LT 模式以其独特的触发特性,在一些特定的应用场景中发挥着重要作用。由于它对数据处理及时性要求不高,逻辑处理相对简单,所以非常适合一些简单的网络服务。比如小型的 Web 服务器,这类服务器通常处理的并发连接数较少,业务逻辑也不复杂,可能只是简单地返回一些静态页面或者处理少量的动态请求 。

在这种情况下,使用 LT 模式可以降低开发的难度,开发者无需过多考虑数据一次性处理完的问题,可以按照常规的顺序逐步处理数据,减少出错的概率 。再比如一些内部系统的 API 服务,这些服务往往只面向内部的少量用户,对性能的要求不是特别高,使用 LT 模式可以快速搭建起服务,并且易于维护和调试 。

4.2 ET模式的适用场景ET 模式则是高并发、对效率要求极高场景的 “宠儿”。以 Nginx 为例,作为一款高性能的 Web 服务器,Nginx 每天要处理海量的并发请求,在这种情况下,ET 模式的优势就凸显出来了 。由于 ET 模式只在事件状态发生变化时触发一次,这就大大减少了不必要的事件触发,降低了系统开销,使得 Nginx 能够在高并发的环境下高效地处理大量请求 。

再比如一些实时系统,如股票交易系统、实时通信系统等,这些系统对延迟和事件的精确控制要求极高,ET 模式可以确保在数据到达的第一时间触发通知,并且通过一次性处理完数据的方式,保证系统的实时性和准确性 。

4.3 如何根据需求选择在选择 LT 或 ET 模式时,需要综合考虑多个因素。从项目需求来看,如果项目的并发量较低,业务逻辑简单,且开发周期较短,那么 LT 模式是一个不错的选择,它可以快速实现功能,降低开发成本 。如果项目面临高并发的场景,对性能要求苛刻,那么 ET 模式更能满足需求,虽然开发难度会有所增加,但可以获得更高的效率和更好的性能表现 。

从开发难度来说,LT 模式编程相对简单,易于理解和调试,适合初学者或者对性能要求不是特别高的项目;而 ET 模式需要开发者对非阻塞 I/O 和数据处理有更深入的理解,编程难度较大,适合有一定经验的开发者 。在实际的项目中,也可以根据不同的业务模块来选择不同的模式,比如对一些核心的、高并发的业务模块使用 ET 模式,而对一些辅助性的、并发量较低的模块使用 LT 模式,从而达到性能和开发效率的平衡 。

Part5epoll使用中的注意事项

5.1 常见问题及解决方案在使用 epoll 时,开发者常常会遇到一些棘手的问题,其中 ET 模式下数据读取不完整以及 epoll 惊群问题较为典型。

在 ET 模式下,数据读取不完整是一个常见的 “陷阱”。由于 ET 模式的特性,只有当文件描述符的状态发生变化时才会触发事件通知。在读取数据时,如果没有一次性将缓冲区中的数据全部读完,后续即使缓冲区中仍有剩余数据,只要状态不再变化,就不会再次触发可读事件通知。这就导致可能会遗漏部分数据,影响程序的正常运行。

例如,在一个网络通信程序中,客户端向服务器发送了一个较大的数据包,服务器在 ET 模式下接收数据。如果服务器在第一次读取时只读取了部分数据,而没有继续读取剩余数据,那么剩余的数据就会被 “遗忘”,导致数据传输的不完整。解决这个问题的关键在于,当检测到可读事件时,要循环读取数据,直到read函数返回EAGAIN错误,表示缓冲区中已无数据可读。这样才能确保将缓冲区中的数据全部读取完毕,避免数据丢失 。

epoll惊群问题也是使用epoll时需要关注的重点。epoll惊群通常发生在多个进程或线程使用各自的epoll实例监听同一个socket的场景中。当有事件发生时,所有阻塞在epoll_wait上的进程或线程都会被唤醒,但实际上只有一个进程或线程能够成功处理该事件,其他进程或线程在处理失败后又会重新休眠。这会导致大量不必要的进程或线程上下文切换,浪费系统资源,降低程序性能。在一个多进程的 Web 服务器中,多个工作进程都使用 epoll 监听同一个端口。当有新的 HTTP 请求到来时,所有工作进程的epoll_wait都会被唤醒,但只有一个进程能够成功接受连接并处理请求,其他进程的唤醒操作就成为了无效的开销。

为了避免epoll 惊群问题,可以使用epoll的EPOLLEXCLUSIVE模式,该模式在 Linux 4.5 + 内核版本中可用。当设置了EPOLLEXCLUSIVE标志后,epoll 在唤醒等待事件的进程或线程时,只会唤醒一个,从而避免了多个进程或线程同时被唤醒的情况,有效减少了系统资源的浪费 。同时,也可以结合使用SO_REUSEPORT选项,每个进程或线程都有自己独立的 socket 绑定到同一个端口,内核会根据四元组信息进行负载均衡,将新的连接分配给不同的进程或线程,进一步优化高并发场景下的性能 。

5.2 性能优化建议为了充分发挥 epoll 的优势,提升程序性能,我们可以从以下几个方面进行优化:

合理设置epoll_wait的超时时间至关重要。epoll_wait的timeout参数决定了等待事件发生的最长时间。如果设置为 - 1,表示无限期等待,直到有事件发生;设置为 0,则立即返回,不等待任何事件;设置为正数,则等待指定的毫秒数。在实际应用中,需要根据具体业务场景来合理选择。

在一些对实时性要求极高的场景,如在线游戏服务器,可能需要将超时时间设置为较短的值,以确保能够及时响应玩家的操作。但如果设置得过短,可能会导致频繁的epoll_wait调用,增加系统开销。因此,需要通过测试和调优,找到一个平衡点,既能满足实时性需求,又能降低系统开销。可以根据业务的平均响应时间和事件发生的频率来估算合适的超时时间,然后在实际运行中根据性能指标进行调整 。

批量处理事件也是提高 epoll 性能的有效方法。当epoll_wait返回多个就绪事件时,一次性处理多个事件可以减少函数调用和上下文切换的开销。在一个高并发的文件服务器中,可能同时有多个客户端请求读取文件。当epoll_wait返回多个可读事件时,可以将这些事件对应的文件描述符放入一个队列中,然后批量读取文件数据。可以使用线程池或协程来并行处理这些事件,进一步提高处理效率。通过批量处理事件,能够充分利用系统资源,提高程序的吞吐量 。

使用EPOLLONESHOT事件可以避免重复触发带来的性能问题。对于注册了EPOLLONESHOT的文件描述符,操作系统最多触发其上注册的一个可读、可写或者异常的事件,且只触发一次,除非使用epoll_ctl函数重置该文件描述符上注册的EPOLLONESHOT事件。这在多线程环境中尤为重要,它可以确保一个 socket 在同一时刻只被一个线程处理,避免多个线程同时操作同一个 socket 导致的竞态条件。

在一个多线程的网络爬虫程序中,每个线程负责处理一个网页的下载和解析。通过为每个socket设置EPOLLONESHOT事件,可以保证每个socket在下载过程中不会被其他线程干扰,提高程序的稳定性和性能。在处理完事件后,要及时重置EPOLLONESHOT事件,以便该socket在后续有新事件发生时能够再次被触发 。