避免性能陷阱:Linux用户态与内核态切换实战

做 Linux 开发时,你是否遇过这种 “诡异” 场景?代码逻辑查了好几遍没漏洞,单机压测却始终卡着 QPS 瓶颈 ——CPU 没跑满,内存也没溢出,排查半天找不到性能卡点。其实你可能踩了个容易被忽略的 “隐性陷阱”:用户态与内核态的频繁切换。Linux 靠用户态 / 内核态隔离保障安全,但两者切换从不是 “零成本”:每次跳转都要保存用户态寄存器、切换页表、校验权限,再恢复内核态上下文,单此开销就达几十到几百个 CPU 时钟周期。要是程序里藏着频繁触发切换的操作 —— 比如循环调用 read/write 处理小数据、用信号量做高频同步,或是误把内核态接口当用户态函数用,这些 “细碎开销” 会悄悄啃掉性能,让程序跑不出预期效率。

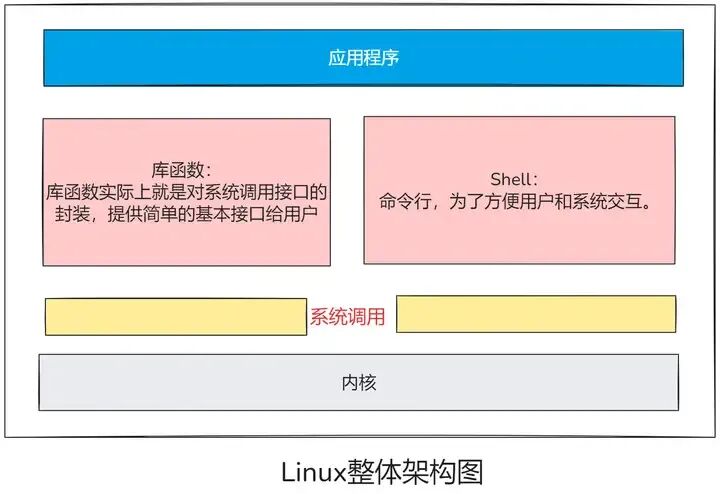

Linux 内核态的实现,本质是通过硬件架构、地址空间隔离、用户态与内核态切换机制三大支柱,构建了一个既高效又安全的系统核心。从用户态发起系统调用到内核态完成资源分配,每一步都经过精密设计,确保应用程序在受限环境中运行,同时让内核能够高效管理硬件资源。理解内核态的工作原理,不仅是操作系统开发者的必修课,也是优化系统性能、排查底层问题的关键切入点。对于开发者而言,掌握内核态与用户态的交互逻辑(如系统调用参数验证、中断处理异步化),能更深入地理解程序行为,写出更健壮的代码;对于技术爱好者,这一层 “特权世界” 的运行机制,正是 Linux 系统稳定与高效的核心密码。

一、用户态与内核态:操作系统的双重世界

在 Linux 的世界里,程序的运行存在着两种截然不同的模式,就像是一个王国中普通民众和皇室成员的区别,这两种模式分别是用户态(User Mode)与内核态(Kernel Mode)。

图片

图片

1.1用户态与内核态概述

先来说说用户态,它是普通应用程序运行的环境,就好比一个被精心规划和限制的 “受控实验室”。在这个环境里,程序的权限受到了严格的约束,不能直接访问硬件资源,比如 CPU、内存以及各种外设 。打个比方,你日常使用的浏览器,当你在浏览器中浏览网页、观看视频时,浏览器这个程序就运行在用户态。它无法擅自去直接操控计算机的硬件,只能通过系统调用这个 “传声筒”,向内核 “申请服务”。再比如文本编辑器,当你用它来撰写文档时,它也处于用户态,不能直接对硬件下达指令。

而内核态则完全不同,它是操作系统内核运行的模式,拥有至高无上的特权,堪称 Linux 系统的 “特权司令部”。内核态就如同数据中心里那个手握所有设备密钥的管理员,能直接操控硬件资源,管理内存的分配,调度进程的运行。当系统需要分配内存给某个程序时,内核态就会发挥作用,合理地划分内存空间;在进程调度方面,比如当多个程序同时运行时,内核态会根据一定的算法,决定哪个程序优先获得 CPU 的执行权,确保系统高效、稳定地运行。像设备驱动程序,它们需要与硬件直接交互,所以也是运行在内核态。

用户态和内核态的核心区别十分关键。用户态程序即便因为某些错误或者异常而崩溃,由于它无法触及系统的核心部分,所以不会影响内核的稳定性,就好比一个普通居民的失误不会影响到整个皇室的统治;然而内核态一旦出现错误,那可就如同皇室发生了动荡,很可能导致系统整体瘫痪,整个计算机系统都无法正常工作 。这也是为什么对内核态的管理和维护需要格外谨慎和严格。

1.2权限分级与运行机制

内核态(Kernel Mode),可谓是操作系统的 “特权阶层”,拥有对硬件资源的绝对掌控权。它能执行一系列特权指令,像内存映射,这可是决定程序如何使用内存空间的关键操作;还有中断管理,负责处理硬件设备发出的各种信号,保障系统有条不紊地运行。从功能上看,内存分配关乎程序能否获得足够的内存来存储数据和执行代码,进程调度则决定了各个程序在 CPU 上的执行顺序,这些核心任务都由内核态承担 。

与之相对的用户态(User Mode),就像是生活在 “受限区域” 的普通居民 —— 应用程序。在用户态下,程序无法直接触碰硬件资源,只能通过系统调用这个 “特殊通道”,向内核态请求服务。这种限制是一种保护机制,能确保恶意程序或者程序中的错误操作,不会轻易地直接破坏系统的稳定性。打个比方,用户态程序就像是在一个有围栏的院子里活动,而系统调用就是打开围栏门的钥匙,只有通过它,程序才能进入内核态的 “大院子” 获取更高级的服务。

在硬件层面,CPU 指令集权限的设计是实现这种隔离的关键。以常见的 x86 架构为例,它划分了 Ring 0 - Ring 3 四个权限级别,其中 Linux 系统主要利用 Ring 0(内核态)和 Ring 3(用户态) 。Ring 0 权限最高,可以使用所有 CPU 指令集,而 Ring 3 权限最低,仅能使用常规 CPU 指令集,无法操作硬件资源,比如进行 I/O 读写、网卡访问、申请内存等。从内存空间划分角度,在 32 位系统中,用户空间被限制在 0 - 3GB,内核空间则占据 3 - 4GB。用户态程序只能操作自己的 0 - 3GB 低位虚拟空间地址,而 3 - 4GB 的高位虚拟空间地址,特别是涉及内核代码和数据的部分,必须由内核态来操作,这就像不同的房间,有不同的进入权限,进一步保障了系统的安全性和稳定性。

1.3切换触发场景

用户态与内核态之间的切换,主要由以下三种场景触发:

(1)主动系统调用:这是用户态程序主动发起的切换。在日常编程中,我们经常会用到 read ()、write () 等函数,当调用这些函数时,实际上就是在发起系统调用。以一个简单的文件读取操作为例,当我们编写的程序需要从文件中读取数据时,就会调用 read ()函数。这个函数会触发一个软中断,在x86架构中,通常是int 0x80指令。这个软中断就像是给内核发送了一个 “紧急求助信号”,CPU接收到这个信号后,会暂停当前用户态程序的执行,将程序的上下文(包括寄存器状态、程序计数器等)保存起来,然后切换到内核态,由内核来处理这个文件读取请求。内核完成读取操作后,再将结果返回给用户态程序,并恢复之前保存的上下文,让用户态程序继续执行 。

(2)硬件中断 / 异常:硬件设备的一些操作也会引发用户态到内核态的切换。比如,当我们在使用电脑时,键盘输入字符、硬盘完成读写操作等情况发生时,硬件设备会向 CPU 发送中断信号。以键盘输入为例,当我们按下键盘上的某个按键时,键盘控制器会检测到这个动作,并生成一个硬件中断信号发送给 CPU。此时,CPU 正在执行用户态的程序,接收到中断信号后,它会立即暂停当前程序的执行,切换到内核态。在内核态下,操作系统的中断处理程序会接管控制权,处理这个键盘中断,比如读取按键值、更新键盘缓冲区等。处理完成后,CPU 再通过特定的机制(如中断返回指令)切换回用户态,继续执行被中断的用户程序。另外,当 CPU 检测到用户态程序执行了非法操作,比如除零、访问未初始化的指针等,就会产生异常,也会强制切换至内核态进行处理。

(3)陷阱指令:如果用户态程序不小心执行了特权指令,这是不被允许的,会触发陷阱指令,进而引发异常,内核态就会接管处理这个问题。例如,用户态程序尝试直接修改中断表,这是只有内核态才能进行的特权操作,一旦执行,就会触发陷阱指令,CPU 切换到内核态,由内核来决定如何处理这个违规行为,可能是记录错误信息、终止进程等 。他们的工作流程如下:

当用户态程序需要请求操作系统提供的服务时,它会将所需的数据值存入寄存器,或通过参数构建一个栈帧(stack frame),以明确标识所需的服务类型及其参数。随后,程序执行一条陷阱指令(trap instruction)。此时,CPU 自动切换至内核态,并跳转到内存中预先指定的位置开始执行指令。该位置存放的操作系统代码具有内存保护机制,禁止用户态程序直接访问。这段代码被称为陷阱处理程序(trap handler)或系统调用处理器(system call handler)。处理程序会读取之前由用户态程序存储在寄存器或栈中的参数,并根据请求执行相应的服务操作。完成系统调用后,操作系统将 CPU 状态恢复为用户态,同时返回系统调用的执行结果。当一个任务(进程)通过执行系统调用进入内核代码执行时,该进程即处于内核态。此时处理器处于最高特权级(通常为 Intel CPU 的 Ring 0),执行操作系统内核提供的代码。在内核态下,所有操作都使用当前进程的内核栈——每个进程都拥有独立的内核栈空间。相反,当进程正在执行用户自定义代码时,则处于用户态,此时处理器运行在最低特权级(如 Ring 3),只能访问用户空间资源。若用户程序在执行过程中被中断(例如硬件中断或异常),尽管其本身仍属于用户态进程,中断处理过程会使用该进程的内核栈,并在内核特权级别下运行,因此也可象征性地视为“进入了内核态”。

需要明确的是,“内核态”与“用户态”是操作系统对运行权限的抽象划分,并不完全依赖于特定硬件架构。例如 Intel x86 架构提供了 Ring 0 到 Ring 3 四个特权级别,Linux 仅使用 Ring 0 作为内核态、Ring 3 作为用户态,未使用中间两级(Ring 1、Ring 2)。用户态程序无法直接访问内核态的代码和数据,例如在 Linux 中,内核地址空间(3GB–4GB)为所有进程共享,存放核心代码及数据结构;而用户地址空间(0–3GB)为各进程独立私有。

当用户程序需执行受限操作(如文件读写或网络通信)时,必须通过 write、send 等系统调用接口触发切换至 Ring 0,进入内核地址空间执行相应功能,完成后再返回 Ring 3。这种机制有效隔离了用户程序与内核资源,提升了系统安全性和稳定性。此外,操作系统通过保护模式中的内存管理机制(如页表)确保进程间地址空间相互隔离,防止某一进程误修改或其他进程的数据或代码。

二、硬件架构:特权级的 “物理护城河”

硬件架构在 Linux 内核态的实现中扮演着基石的角色,就如同城堡的坚固城墙和护城河,为内核态的特权运行提供了坚实的物理基础和安全保障 。其中,CPU 的特权级划分机制是实现内核态与用户态分离的关键硬件支持。不同的 CPU 架构,如 x86 和 ARM,虽然都实现了特权级的划分,但在具体的实现方式和细节上却有着各自的特点。

先明确一个核心逻辑:没有硬件级别的特权隔离,内核态的 “特权” 就是空中楼阁。操作系统之所以能管住用户程序,本质是 CPU 在硬件层面划分了 “权限等级”—— 不同等级能执行的指令、访问的内存完全不同。就像公司门禁:普通员工(用户态)只能进办公区,而 CEO(内核态)能进服务器机房。

Linux 内核正是利用了 CPU 的这种硬件特性,将 “内核态” 绑定到最高特权级,“用户态” 绑定到最低特权级,中间的特权级则根据需求灵活使用。但不同 CPU 架构的 “门禁设计” 差异很大,最典型的就是 x86 的 “Ring 分级” 和 ARM 的 “异常等级(EL)”。

2.1 x86 架构:四级特权环的简化应用

x86 作为 PC 和服务器领域的 “老大哥”,采用了经典的四级特权级(Ring 0 ~ Ring 3) 设计,就像四层嵌套的防护盾,权限从 Ring 0 到 Ring 3 逐级递减。

(1)特权级核心规则:谁能做什么?Ring 0(内核态专属):最高特权级,能执行所有 CPU 指令(如修改 CR0 寄存器、操作 IO 端口),可访问所有物理内存。Linux 内核的进程调度、内存管理、中断处理等核心模块,全在 Ring 0 运行。Ring 1~2(几乎不用):中间特权级,理论上可用于驱动或虚拟化,但 Linux 为了简化设计,直接跳过这两级 —— 毕竟 “四层防护” 对多数场景来说太复杂,不如 “内核(Ring0)+ 用户(Ring3)” 的两级模型高效。Ring 3(用户态专属):最低特权级,只能执行普通指令(如加减运算、函数调用),访问的内存被严格限制在进程自己的虚拟地址空间。一旦用户程序想执行特权指令(如直接读写硬盘),CPU 会立刻触发 “异常”,把控制权交给 Ring 0 的内核处理(相当于 “门禁报警,保安接管”)。(2)关键硬件组件:如何实现 “权限检查”?x86 靠三个核心硬件机制确保特权级不被突破:

代码段描述符(CS 寄存器):每个程序的代码段都有一个 “描述符”,其中的 “DPL(描述符特权级)” 字段标明了该代码段所属的特权级。比如内核代码段的 DPL=0,用户代码段的 DPL=3。当前特权级(CPL):CPU 通过 CS 寄存器的最低两位,实时记录当前运行程序的特权级(即 CPL)。比如执行内核代码时,CPL=0;执行用户程序时,CPL=3。权限检查逻辑:当程序尝试访问某个资源(如调用系统调用、访问内存)时,CPU 会对比 “CPL” 和 “目标资源的 DPL”—— 只有 CPL 权限≥目标 DPL,才能允许访问。比如用户态(CPL=3)想调用内核函数(DPL=0),直接访问会被拒绝,必须通过 “系统调用” 触发特权级切换。x86 的系统调用如何切换特权级?以 Linux 中最经典的read()系统调用为例,x86 上的特权级切换流程就依赖硬件机制:

用户程序(Ring3)执行int 0x80指令(软中断),触发 CPU 硬件中断;CPU 检测到int 0x80,自动将当前 Ring3 的寄存器(如 eax、ebx)保存到内核栈,然后从 “中断描述符表(IDT)” 中找到对应的内核处理函数;CPU 将 CS 寄存器的特权级从 3 改为 0(CPL=0),跳转到内核的系统调用处理函数(Ring0);内核处理完read()请求后,执行iret指令,恢复 Ring3 的寄存器,将 CPL 切回 3,回到用户程序。这里有个优化点:早期 x86 用int 0x80切换,后来引入sysenter/sysexit指令 —— 前者切换耗时约 100 纳秒,后者仅需 30 纳秒,原因是sysenter直接跳过了部分 IDT 查表步骤,靠硬件快速切换特权级。这就是硬件特性影响内核性能的典型案例。

2.2 ARM 架构:异常级别的安全屏障

ARM 架构(手机、嵌入式、服务器都在用)没有采用 x86 的 Ring 设计,而是用异常等级(Exception Level,简称 EL) 划分特权,更贴合低功耗和实时性需求。不同 ARM 版本(v7、v8)的 EL 划分还不一样,我们重点讲现在主流的 ARMv8(64 位)。

(1)ARMv8 的特权级:EL0~EL3,分工更明确ARMv8 将特权级分为 4 级(EL0 最低,EL3 最高),每级的定位比 x86 更清晰:

EL0(用户态):普通应用程序运行的等级,权限最低,不能执行特权指令(如修改页表),对应 Linux 的用户态进程;EL1(内核态):Linux 内核的专属等级,能执行大部分特权指令(如内存管理、中断处理),但不能访问 “安全世界” 的资源;EL2(虚拟化):专门给虚拟化软件(如 KVM)用的等级,负责管理虚拟机,避免虚拟机直接操作 EL1 的内核资源;EL3(安全监控):最高特权级,负责 “安全世界” 与 “正常世界” 的切换(如指纹识别、加密密钥管理),由 TrustZone 技术管控,Linux 内核通常不直接使用。对比 x86:ARM 的 EL 划分更聚焦 “功能场景”—— 比如 EL2 专门给虚拟化,避免了 x86 用 Ring0 模拟虚拟化的低效问题。这也是 ARM 服务器在虚拟化场景下性能优势的原因之一。

(2)核心硬件差异:与 x86 的 “本质不同”ARM 的特权级实现,和 x86 有三个关键区别,直接影响 Linux 内核的运行:

没有 “中间特权级浪费”:x86 的 Ring1~2 几乎闲置,而 ARM 的 EL0~EL3 每级都有明确用途(EL2 给虚拟化,EL3 给安全),Linux 内核在 ARM 上能更高效地利用硬件特权;特权切换依赖 “异常” 而非 “中断”:x86 用软中断(int 0x80)切换特权级,而 ARM 用 “异常”(如 SVC 指令)—— 用户态(EL0)执行SVC #0指令(Supervisor Call,管理调用),会触发 “SVC 异常”,CPU 自动切换到 EL1 的内核态;寄存器状态由软件管理:x86 切换特权级时,硬件会自动保存部分寄存器,而 ARMv8 需要内核自己编写代码保存 EL0 的寄存器(如 x0~x31)—— 这虽然增加了内核代码的复杂度,但让内核能根据场景灵活优化(比如只保存需要的寄存器,减少切换开销)。(3)ARM 与 x86 的特权级兼容问题很多开发者在跨架构移植 Linux 程序时,会踩特权级的坑。比如:

案例 1:误将 x86 的 Ring0 逻辑移植到 ARM:某开发者在 ARM 平台写驱动时,想直接访问 EL3 的安全寄存器,结果 CPU 触发 “权限异常”—— 因为 ARM 的 EL1(内核态)不能访问 EL3 的资源,而 x86 的 Ring0 能访问所有资源,两者特权范围完全不同;案例 2:中断处理的特权差异:x86 的中断处理默认在 Ring0,而 ARM 的中断(IRQ)默认在 EL1—— 但如果开启了 TrustZone,部分中断会被路由到 EL3,此时 Linux 内核(EL1)无法处理,必须通过 EL3 的监控程序转发。这就是为什么 ARM 服务器的中断配置比 x86 复杂。2.3Linux 内核如何适配两种架构?

既然 x86 和 ARM 的特权级实现差异这么大,Linux 内核是如何做到 “一套代码跑遍所有架构” 的?答案是架构抽象层(Architecture Abstraction Layer)。

内核在arch/目录下为不同架构创建了专属代码:

arch/x86/:实现 x86 的特权级切换(如sysenter指令封装)、中断处理(IDT 表管理);arch/arm64/:实现 ARMv8 的 EL 切换(如 SVC 异常处理)、寄存器保存逻辑;上层核心代码(如kernel/sched/进程调度、mm/内存管理)则通过统一的接口(如schedule()调度函数、do_syscall()系统调用处理)调用抽象层,完全不用关心底层是 Ring0 还是 EL1。举个例子:Linux 的系统调用表,x86 在arch/x86/entry/syscalls/syscall_64.tbl定义,ARM64 在arch/arm64/include/asm/syscall.h定义,但上层程序调用read()时,都是通过统一的SYSCALL_DEFINE3(read, ...)宏注册,底层差异被完全屏蔽。

三、内核态与用户态的交互

由于内核态的 “特权” 性质,它不能被用户态程序直接进入,必须通过特定的机制,就像进入一个高度机密的区域需要特定的通行证和安检流程一样 。在 Linux 中,主要有三种途径可以从用户态切换到内核态,分别是系统调用、硬件中断和软件异常。

3.1系统调用:用户态的 “官方申请”

系统调用是用户态程序主动向内核请求服务的方式,就像是普通民众向政府部门提交正式的服务申请 。当用户态程序需要访问硬件资源或者执行一些特权操作时,比如读取文件内容、创建新进程,它必须通过系统调用这一 “官方渠道” 来实现。

在不同的硬件架构上,系统调用有着不同的触发方式。以 x86 架构为例,传统的方式是使用 int 0x80 软中断指令 ,这条指令就像是一把特殊的 “钥匙”,能够打开从用户态进入内核态的大门。后来,为了提高系统调用的效率,又引入了 sysenter 指令,它就像是一条 “绿色通道”,让系统调用的过程更加快速。而在 ARM 架构中,则使用 svc 指令来触发系统调用。

系统调用的处理流程相当严谨,堪称一场有条不紊的 “程序接力赛” 。当用户态程序执行系统调用指令时,CPU 首先会将当前用户态的上下文信息,包括寄存器的值、程序计数器等,就像是运动员的装备和比赛进度,保存到内核栈中;接着,CPU 会根据系统调用号,就像是根据服务申请编号,在 sys_call_table 这张 “服务目录表” 中查找对应的内核函数,比如 sys_read 函数,然后执行该函数;当内核处理完用户的请求后,会通过 iret/eret 指令,就像是吹响比赛结束的哨声,恢复之前保存的用户态上下文,程序从断点处继续执行,就像运动员从暂停的地方继续比赛。

3.2硬件中断:外设的 “紧急呼叫”

硬件中断是由外部设备(如硬盘、网卡等)触发的,当这些外设完成某项操作或者需要 CPU 的关注时,就会通过中断控制器向 CPU 发送一个信号,就像是紧急事件发生时拨打的 “110 报警电话” ,CPU 在接收到这个信号后,会暂停当前正在执行的任务,迅速切换到内核态,执行相应的中断处理程序,就像是警察迅速出警处理紧急事件。

例如,当硬盘完成数据读取操作后,它会向 CPU 发送中断信号 ,此时,内核态的代码就会接手工作,负责将读取到的数据拷贝到用户缓冲区,就像是快递员将包裹送到收件人手中。在处理完这个中断后,CPU 会返回用户态,继续执行之前被暂停的任务,就像是警察处理完事件后回到原来的工作岗位。硬件中断的处理速度非常关键,因为外设的操作往往是异步的,如果不能及时响应,可能会导致数据丢失或者系统性能下降,就像是紧急事件如果不能及时处理,可能会造成严重后果。

3.3软件异常:程序错误的 “兜底处理”

软件异常是由于用户态程序自身的错误或者特殊指令的执行而触发的 ,比如当程序尝试访问未分配的内存,就像在一个没有门牌号的地方找房子,或者进行除零操作,就像做一件不符合数学规则的事情时,CPU 会触发异常并进入内核态,就像是启动了一个 “错误处理应急机制”。

以内核态的缺页处理函数为例,当用户态程序访问一个不存在的内存页时 ,缺页处理函数就会被调用。它会尝试为程序分配物理内存,并更新页表,就像是为程序找到合适的房子并登记好地址信息。如果这个过程中无法解决问题,比如没有足够的内存可用,那么内核可能会选择终止这个进程,就像是因为无法解决问题而取消了一个项目。软件异常处理机制是 Linux 系统的重要保障,它能够在程序出现错误时,尽可能地进行修复或者妥善处理,避免系统的崩溃,就像是一个兜底的安全网,保护着系统的稳定运行。

四、内核态核心组件:系统运行的 “幕后引擎”

内核态之所以能成为 Linux 系统的 “特权司令部”,离不开其内部一系列核心组件的协同工作 。这些组件就像是一个庞大工厂里的各个关键部门,各自承担着重要职责,共同维持着系统的稳定运行。接下来,我们将深入剖析进程管理、内存管理和中断管理这三个关键组件。

4.1进程管理:调度器的 “资源分配术”

进程管理是内核态的核心职责之一,它就像是一位经验丰富的资源分配大师,负责管理系统中所有进程的创建、调度和终止,确保每个进程都能合理地获取 CPU 资源,从而实现多任务的高效并行执行 。

内核通过 task_struct 结构体来全面记录进程的各种状态信息,这个结构体就像是进程的 “个人档案”,包含了进程 ID、优先级、程序计数器、寄存器状态、内存映射等关键信息 。进程 ID 就如同每个人的身份证号码,是进程的唯一标识;优先级决定了进程获取 CPU 资源的先后顺序,就像在排队时,优先级高的人可以优先办理业务;程序计数器记录了进程当前执行的指令位置,确保进程能从上次中断的地方继续执行;寄存器状态保存了进程运行时 CPU 寄存器的值,就像运动员比赛时携带的装备状态;内存映射则记录了进程的内存使用情况,明确了进程可以访问的内存区域。

在进程创建方面,主要依赖 fork ()/vfork () 系统调用 。当用户态程序调用这些系统调用时,内核态会进行一系列复杂的操作。首先,内核会为新进程分配一个唯一的进程 ID,就像是为新员工分配一个专属的工号;然后,复制父进程的 task_struct 结构体,就像是复制一份旧档案,再根据新进程的需求进行适当修改;接着,为新进程分配独立的内存空间,就像为新员工安排独立的办公区域;最后,将新进程添加到就绪队列中,等待 CPU 的调度,就像新员工准备好接受工作任务分配。

进程调度是进程管理的关键环节,它决定了哪个进程将获得 CPU 的执行权 。在内核态下,调度器通过特定的调度算法(如完全公平调度算法 CFS)和 pick_next_task () 函数来精心选择下一个运行的进程 。CFS 算法就像是一个公平的裁判,它为每个进程分配一个虚拟运行时间,根据虚拟运行时间的长短来决定进程的调度顺序,确保每个进程都能得到公平的 CPU 时间分配。pick_next_task () 函数则像是一个任务分配器,它根据调度算法的结果,从就绪队列中挑选出下一个最合适的进程。

在内核态下,调度器可以直接操作进程上下文,这就像是一个拥有最高权限的管理员,可以直接进入各个房间进行操作 。在进行进程切换时,调度器会仔细保存当前进程的寄存器信息、程序计数器等上下文数据,就像是把运动员比赛时的装备和比赛进度记录下来;然后,恢复下一个进程的上下文,就像是为下一个运动员准备好比赛装备,让其能够顺利上场比赛。这样,通过高效的进程调度和上下文切换,Linux 系统能够在多个进程之间快速切换,实现多任务的并发执行,让用户感觉多个程序在同时运行,极大地提高了系统的效率和响应速度。

4.2内存管理:从物理到虚拟的 “翻译官”

内存管理是内核态的另一项重要职责,它如同一位精准的翻译官,负责管理系统的物理内存和虚拟内存,为每个进程分配合理的内存空间,并建立起物理地址与虚拟地址之间的映射关系 ,确保进程能够安全、高效地访问内存。

在内核态中,物理内存的分配主要由伙伴系统(Buddy System)和 slab 缓存(Slab Cache)来协同完成 。伙伴系统就像是一个大型的仓库管理员,负责管理大块连续的物理内存 。当进程需要申请较大的内存块时,伙伴系统会根据内存的大小和空闲情况,从内存池中分配合适的内存块给进程。它采用了一种巧妙的算法,将内存按照不同的大小进行分组,当有内存释放时,会尝试合并相邻的空闲内存块,以减少内存碎片,提高内存的利用率。

slab 缓存则像是一个小型的零件库,专门用于优化小对象的分配 。对于一些频繁使用的小对象,如内核中的各种数据结构(task_struct、file 等),如果每次都从伙伴系统中分配内存,会产生大量的内存碎片,降低系统性能。slab 缓存会预先分配一些内存块,并将其划分为多个小的对象单元,当有小对象需要分配时,直接从 slab 缓存中获取,这样可以大大提高分配效率,减少内存碎片的产生。

虚拟地址映射是内存管理的核心功能之一,它让每个进程都拥有独立的虚拟地址空间,就像是为每个进程提供了一个独立的 “地址舞台” 。在这个舞台上,进程可以自由地访问内存,而无需关心物理内存的实际布局。mm_struct 结构体就像是这个舞台的 “导演”,负责管理进程的虚拟地址空间 。它记录了虚拟地址空间的范围、各个区域的属性(如代码段、数据段、堆、栈等)以及与物理内存的映射关系。

vmalloc () 函数是分配非连续虚拟内存的重要工具,它就像是一个灵活的场地规划师,可以在虚拟地址空间中分配一块不连续的内存区域 。当进程需要一块较大的、不连续的内存时,vmalloc () 函数会在虚拟地址空间中找到合适的位置,并建立起与物理内存的映射关系。不过,由于虚拟地址与物理地址的映射需要通过页表来实现,这种不连续的映射会增加地址转换的开销,所以 vmalloc () 函数通常用于分配一些对性能要求不是特别高,但需要较大内存空间的场景。

ioremap () 函数则是用于映射外设寄存器地址的特殊 “桥梁” 。在计算机系统中,外设(如显卡、网卡等)都有自己的寄存器,这些寄存器需要通过内存映射的方式才能被 CPU 访问。ioremap () 函数可以将外设寄存器的物理地址映射到虚拟地址空间中,就像是在 CPU 和外设之间搭建了一座桥梁,让 CPU 能够像访问内存一样访问外设寄存器,从而实现对外设的控制和数据传输。

通过页表机制,内核态能够精确地控制每个进程的内存访问权限 ,这就像是一个严格的门禁系统,确保每个进程只能访问自己被授权的内存区域。页表是一个存储虚拟地址与物理地址映射关系的数据结构,它就像是一本地址翻译字典,记录了每个虚拟地址对应的物理地址。在页表项中,还包含了访问权限位,如只读、读写、可执行等。当进程访问内存时,CPU 会根据页表进行地址转换,并检查访问权限。如果进程试图访问未授权的内存区域,就像一个没有权限的人试图进入禁区,CPU 会立即触发页错误异常,由内核态进行处理,以防止进程越界读写,保证系统的稳定性和安全性。

4.3中断管理:硬件事件的 “有序调度员”

中断管理是内核态处理硬件事件的关键机制,它就像是一个高效的调度员,负责处理来自硬件设备的各种中断请求,确保硬件事件能够得到及时、有序的处理 。

内核通过 irq_desc 结构体来全面管理中断 ,这个结构体就像是中断的 “管理档案”,包含了中断号、中断处理函数指针、中断状态等重要信息 。中断号就像是事件的编号,用于唯一标识每个中断请求;中断处理函数指针指向了处理该中断的具体函数,就像每个事件都有对应的处理人员;中断状态记录了中断的当前状态,如是否被屏蔽、是否正在处理等。

request_irq () 函数是注册中断处理函数的重要接口 ,当设备驱动程序需要处理某个硬件中断时,会通过这个函数向内核注册一个中断处理函数,就像是向调度员登记一个事件的处理方案。在注册过程中,需要提供中断号、中断处理函数、中断标志等参数 。中断标志用于指定中断的特性,如是否共享中断、中断触发方式(上升沿触发、下降沿触发、电平触发等)。例如,多个设备可能共享同一个中断号,此时就需要通过中断标志来区分不同设备的中断请求。

mask_irq () 函数则用于屏蔽中断 ,就像是给事件处理按下了暂停键。当内核在执行一些关键操作时,为了避免中断的干扰,可能需要暂时屏蔽某些中断。通过调用 mask_irq () 函数,并传入要屏蔽的中断号,内核可以阻止该中断的处理,确保关键操作的顺利进行。当关键操作完成后,再通过相应的函数解除对中断的屏蔽,恢复中断的正常处理。

Linux 内核支持中断嵌套,这就像是一个繁忙的调度员可以同时处理多个紧急事件 。当中断处理函数正在执行时,如果又有新的中断请求到来,并且新中断的优先级高于当前正在处理的中断,那么内核会暂停当前中断的处理,转而处理新的中断,这就是中断嵌套。不过,在一些关键路径上,如持有自旋锁时,需要特别注意避免中断阻塞 。自旋锁是一种用于保护临界区的同步机制,当一个进程持有自旋锁时,如果发生中断并在中断处理函数中试图获取同一个自旋锁,就会导致死锁,因为自旋锁不会释放 CPU,而是一直等待锁的释放。

为了避免这种情况,内核提供了软中断(Softirq)和工作队列(Workqueue)机制 ,用于异步处理耗时较长的任务,就像是调度员将一些耗时的任务交给专门的团队去处理,避免影响其他紧急事件的处理。软中断是一种比硬件中断优先级稍低的中断机制,它在中断处理的后半部分执行 。tasklet 是软中断的一种实现方式,它可以将一些相对耗时但又不紧急的任务延迟到软中断上下文执行 。

例如,网络设备接收数据时,硬件中断会首先将数据接收下来,然后通过软中断将数据进一步处理并传递给上层协议栈。工作队列则是将任务放到内核线程中执行,它可以处理那些可能会睡眠的任务 。比如,文件系统的一些操作(如写入磁盘)可能会因为等待磁盘 I/O 而睡眠,这种任务就适合放在工作队列中执行,以避免阻塞中断处理流程,确保系统的高效运行和稳定性。

mmap内存映射的实现过程,总的来说可以分为三个阶段:

①进程启动映射过程,并在虚拟地址空间中为映射创建虚拟映射区域

1、进程在用户空间调用库函数mmap,原型:void *mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset);

2、在当前进程的虚拟地址空间中,寻找一段空闲的满足要求的连续的虚拟地址

3、为此虚拟区分配一个vm_area_struct结构,接着对这个结构的各个域进行了初始化

4、将新建的虚拟区结构(vm_area_struct)插入进程的虚拟地址区域链表或树中

②调用内核空间的系统调用函数mmap(不同于用户空间函数),实现文件物理地址和进程虚拟地址的一一映射关系

5、为映射分配了新的虚拟地址区域后,通过待映射的文件指针,在文件描述符表中找到对应的文件描述符,通过文件描述符,链接到内核“已打开文件集”中该文件的文件结构体(struct file),每个文件结构体维护着和这个已打开文件相关各项信息。

6、通过该文件的文件结构体,链接到file_operations模块,调用内核函数mmap,其原型为:int mmap(struct file *filp, struct vm_area_struct *vma),不同于用户空间库函数。

7、内核mmap函数通过虚拟文件系统inode模块定位到文件磁盘物理地址。

8、通过remap_pfn_range函数建立页表,即实现了文件地址和虚拟地址区域的映射关系。此时,这片虚拟地址并没有任何数据关联到主存中。

③进程发起对这片映射空间的访问,引发缺页异常,实现文件内容到物理内存(主存)的拷贝

注:前两个阶段仅在于创建虚拟区间并完成地址映射,但是并没有将任何文件数据的拷贝至主存。真正的文件读取是当进程发起读或写操作时。

9、进程的读或写操作访问虚拟地址空间这一段映射地址,通过查询页表,发现这一段地址并不在物理页面上。因为目前只建立了地址映射,真正的硬盘数据还没有拷贝到内存中,因此引发缺页异常。

10、缺页异常进行一系列判断,确定无非法操作后,内核发起请求调页过程。

11、调页过程先在交换缓存空间(swap cache)中寻找需要访问的内存页,如果没有则调用nopage函数把所缺的页从磁盘装入到主存中。

12、之后进程即可对这片主存进行读或者写的操作,如果写操作改变了其内容,一定时间后系统会自动回写脏页面到对应磁盘地址,也即完成了写入到文件的过程。

注:修改过的脏页面并不会立即更新回文件中,而是有一段时间的延迟,可以调用msync()来强制同步, 这样所写的内容就能立即保存到文件里了。

五、实战优化策略:从原理到代码

了解了用户态与内核态切换带来的性能陷阱后,接下来我们就来探讨一下如何在实际编程中避免这些陷阱,提升系统性能 。下面将从减少系统调用频次、用户态协议栈与内核旁路、异步 IO 与事件驱动、内存映射与零拷贝这几个方面展开,给出具体的优化策略和代码示例 。

5.1减少系统调用频次

系统调用是用户态与内核态切换的主要触发点之一,减少系统调用的频次,就能有效降低切换带来的性能开销 。下面介绍两种常见的方法:

(1)批量操作替代单次调用:在文件 IO 操作中,传统的 read () 和 write () 函数每次只能操作一个缓冲区,如果需要读写多个缓冲区的数据,就需要多次调用,这会导致频繁的用户态与内核态切换 。而 readv () 和 writev () 函数则允许我们一次操作多个缓冲区,减少了系统调用的次数 。例如,我们有一个程序需要读取两个缓冲区的数据,如果使用 read () 函数,代码可能如下:

在这段代码中,进行了两次 read () 系统调用,也就意味着发生了两次用户态与内核态的切换 。如果使用 readv () 函数,代码可以改为:

在这段代码中,只进行了一次 readv () 系统调用,相比之前减少了一次用户态与内核态的切换 。

在网络通信中,sendfile () 函数可以实现零拷贝传输,避免了用户态与内核态间的数据拷贝和多次系统调用 。以一个简单的文件传输为例,传统的做法是先使用 read () 函数从文件中读取数据到用户态缓冲区,再使用 write () 函数将数据写入网络套接字,这个过程需要 4 次用户态 - 内核态切换 。而使用 sendfile () 函数,数据可以直接从内核的文件缓存传输到网络套接字,仅需 2 次用户态 - 内核态切换,大大降低了开销 。代码示例如下:

在这段代码中,sendfile () 函数将文件数据直接从内核的文件缓存传输到网络套接字,避免了数据在用户态与内核态之间的多次拷贝和系统调用,提高了传输效率 。

(2)用户态缓存与预取:对于高频访问的元数据,如文件描述符、网络连接信息等,我们可以在用户态进行缓存,减少重复查询内核的需求 。例如,在一个网络服务器程序中,如果每次处理客户端请求都去查询网络连接信息,会导致频繁的系统调用 。我们可以在程序启动时,将常用的网络连接信息缓存到用户态的内存中,后续直接从缓存中获取,避免了重复查询内核 。代码示例如下:

在这段代码中,init_connection () 函数初始化并缓存了网络连接信息,后续在处理客户端请求时,可以直接使用 cached_conn 中的信息,减少了系统调用 。

利用 posix_fadvise () 函数,我们可以预取文件数据,提前将数据加载至用户态缓冲区,减少后续的 IO 等待时间和系统调用 。例如,在一个视频播放程序中,我们可以提前预取视频文件的下一帧数据,当播放当前帧时,下一帧数据已经在用户态缓冲区中,避免了播放时的卡顿和频繁的系统调用 。代码示例如下:

在这段代码中,posix_fadvise () 函数通知内核我们即将需要指定偏移量和长度的数据,内核会提前将这些数据加载到用户态缓冲区,减少了后续的 IO 等待时间和系统调用 。

5.2用户态协议栈与内核旁路

在一些对性能要求极高的场景中,我们可以绕过内核协议栈,直接在用户态操作网卡,减少用户态与内核态的切换次数 。下面介绍两种常见的技术:

(1)DPDK 技术实践:数据平面开发套件(DPDK)是一套开源库和驱动程序集合,旨在加速包处理和数据平面应用的开发 。在高性能网络场景中,DPDK 允许开发者绕过传统操作系统网络堆栈的限制,通过直接访问硬件设备、优化缓存和提供高效的用户空间数据路径来减少延迟和提高吞吐量 。DPDK 通过轮询模式驱动(PMD)替代中断驱动,避免了中断触发的频繁切换 。传统的网络数据处理中,数据包的接收、处理与转发通常由内核空间来完成,数据需要在用户空间和内核空间之间来回传递,这些操作增加了延迟并限制了系统的吞吐量 。

而 DPDK 能够从用户空间直接访问网络接口卡(NIC),绕过内核协议栈,以减少数据包的拷贝次数和上下文切换 。通过将特定 CPU 核心绑定到特定的任务,DPDK 减少了任务调度的开销并提高了缓存的利用效率 。同时,利用大页内存减少了 TLB(翻译后备缓冲器)的查找次数,提高了内存访问速度 。以一个简单的 DPDK 网络应用为例,代码如下:

在这段代码中,首先初始化 DPDK 环境,然后配置并启动网卡设备 。在循环中,通过 rte_eth_rx_burst () 函数从网卡接收数据包,直接在用户态进行处理,避免了内核协议栈的参与,大大提高了网络处理性能 。某金融交易系统引入 DPDK 后,网络处理延迟从 12μs 降至 2μs,每秒交易处理量提升 300%,充分展示了 DPDK 在高性能网络场景中的优势 。

(2)VPP 矢量包处理:矢量包处理(VPP)是思科旗下的一款可拓展的开源框架,提供容易使用的、高质量的交换、路由功能 。VPP 在用户空间运行,对硬件、内核和部署环境(如裸机、虚拟机、容器)具有高度的通用性 。VPP 的核心技术是将多个数据包聚合成 “矢量” 批量处理,摊薄单次切换成本 。它使用矢量处理而不是标量处理,一次处理多个数据包,解决了 I 缓存抖动问题,缓解了相关的读取延迟问题,改善了电路时间 。在处理数据包时,VPP 从网络 IO 层读取最大的可用包向量,通过一个包处理图来处理包向量,而不是一个一个地处理包 。第一个包使指令缓存 “热身”,其余的包能够以极高的性能被处理,处理包向量的固定成本分摊到整个向量上,从而实现高性能和统计上可靠的性能 。

例如,在 5G 边缘计算等高吞吐量场景中,VPP 可以将多个 5G 数据包聚合成矢量进行处理,提高了数据处理效率和网络吞吐量 。VPP 的插件架构也便于扩展,硬件加速器供应商只需提供一个插件,该插件可以作为输入节点,将处理交给第一个软件节点,或作为输出节点,在软件处理完成后接管,这使得即使在缺少硬件加速器或资源耗尽的情况下,功能也能继续运行 。

5.3异步 IO 与事件驱动

传统的同步 IO 操作会导致线程在等待 IO 完成时被阻塞,浪费了 CPU 资源,并且会引发频繁的用户态与内核态切换 。而异步 IO 和事件驱动机制可以有效解决这些问题 。

(1)异步模型降低阻塞:使用 aio_read ()/aio_write () 或 Linux 内核的 io_uring 机制,我们可以实现异步 IO,通过异步通知减少进程在 IO 等待时的主动切换 。以 aio_read () 为例,代码示例如下:

在这段代码中,通过 aio_read () 发起异步读操作后,程序可以继续执行其他任务,而无需等待读操作完成 。当读操作完成后,通过 aio_error () 和 aio_return () 获取操作结果,减少了线程在 IO 等待时的阻塞和用户态与内核态的切换 。

事件驱动框架,如Nginx、Redis等,通过单线程响应多路 IO 事件,避免了多线程频繁上下文切换 。以Nginx为例,它使用 epoll 机制来监听多个网络连接的事件,当有事件发生时,才会调用相应的处理函数 。这样,Nginx 可以在单线程中高效地处理大量并发请求,减少了线程上下文切换的开销 。Nginx 的核心代码中,通过epoll_wait () 函数等待事件发生,然后根据事件类型调用相应的回调函数,实现了高效的事件驱动模型 。

(2)内核态延迟处理:将非紧急任务,如日志写入、统计信息更新等,合并后批量处理,通过 workqueue 或内核定时器延迟执行,减少即时切换次数 。以日志写入为例,我们可以将多个日志消息先缓存到用户态的缓冲区中,当缓冲区满或者达到一定时间间隔时,再通过一次系统调用将缓冲区中的所有日志消息写入文件 。代码示例如下:

在这段代码中,log_message () 函数将日志消息添加到缓冲区中,当缓冲区满时,通过 write_log () 函数将缓冲区中的所有日志消息写入文件 。这样,相比每次有日志消息就立即写入文件,减少了系统调用的次数和用户态与内核态的切换 。

5.4内存映射与零拷贝

内存映射,听名字就很厉害,它确实是一种高性能的交互机制,就像是一座高效的 “数据高速公路”,能够将文件或设备内存直接映射到用户空间地址空间 。这意味着,用户程序可以直接访问这些内存,而无需经过内核与用户态之间的数据拷贝,大大提高了数据传输效率。

传统的 read + write 操作,就像是接力赛,数据需要在用户空间和内核空间之间进行两次拷贝 ,效率较低。而 mmap 则像是一条直达通道,数据仅需一次拷贝,就能被用户程序直接访问 ,这在处理大文件时,优势尤为明显。比如在数据库 IO 中,大量的数据需要快速读取和写入,mmap 就能大显身手,大大提升数据库的性能。在图形渲染中,需要频繁访问图形缓冲区,mmap 也能通过共享内存的方式,提高渲染效率,让画面更加流畅。

在使用 mmap 时,我们需要通过 mmap 系统调用来创建映射,就像是在这条 “高速公路” 上设置入口。完成操作后,别忘了使用 munmap 释放映射,关闭这条通道,以避免资源浪费。同时,由于多个进程可能同时访问映射内存,所以同步与访问权限控制也非常重要,就像在高速公路上需要遵守交通规则一样,确保各个进程能够安全、有序地访问内存。

mmap内存映射的实现过程,总的来说可以分为三个阶段:

⑴进程启动映射过程,并在虚拟地址空间中为映射创建虚拟映射区域

进程在用户空间调用库函数mmap,原型:void *mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset);在当前进程的虚拟地址空间中,寻找一段空闲的满足要求的连续的虚拟地址为此虚拟区分配一个vm_area_struct结构,接着对这个结构的各个域进行了初始化将新建的虚拟区结构(vm_area_struct)插入进程的虚拟地址区域链表或树中⑵调用内核空间的系统调用函数mmap(不同于用户空间函数),实现文件物理地址和进程虚拟地址的一一映射关系

为映射分配了新的虚拟地址区域后,通过待映射的文件指针,在文件描述符表中找到对应的文件描述符,通过文件描述符,链接到内核“已打开文件集”中该文件的文件结构体(struct file),每个文件结构体维护着和这个已打开文件相关各项信息。通过该文件的文件结构体,链接到file_operations模块,调用内核函数mmap,其原型为:int mmap(struct file *filp, struct vm_area_struct *vma),不同于用户空间库函数。内核mmap函数通过虚拟文件系统inode模块定位到文件磁盘物理地址。通过remap_pfn_range函数建立页表,即实现了文件地址和虚拟地址区域的映射关系。此时,这片虚拟地址并没有任何数据关联到主存中。⑶进程发起对这片映射空间的访问,引发缺页异常,实现文件内容到物理内存(主存)的拷贝

注:前两个阶段仅在于创建虚拟区间并完成地址映射,但是并没有将任何文件数据的拷贝至主存。真正的文件读取是当进程发起读或写操作时。

进程的读或写操作访问虚拟地址空间这一段映射地址,通过查询页表,发现这一段地址并不在物理页面上。因为目前只建立了地址映射,真正的硬盘数据还没有拷贝到内存中,因此引发缺页异常。缺页异常进行一系列判断,确定无非法操作后,内核发起请求调页过程。调页过程先在交换缓存空间(swap cache)中寻找需要访问的内存页,如果没有则调用nopage函数把所缺的页从磁盘装入到主存中。之后进程即可对这片主存进行读或者写的操作,如果写操作改变了其内容,一定时间后系统会自动回写脏页面到对应磁盘地址,也即完成了写入到文件的过程。注:修改过的脏页面并不会立即更新回文件中,而是有一段时间的延迟,可以调用msync()来强制同步, 这样所写的内容就能立即保存到文件里了。

零拷贝(zero-copy)并不是指完全不进行数据拷贝,而是一种通过操作系统内核优化,减少数据在用户空间(User Space)与内核空间(Kernel Space)之间冗余拷贝的技术,甚至完全避免不必要的 CPU 数据搬运,从而显著提升数据传输效率、降低 CPU 占用率。其核心目标可以总结为以下几点:

减少数据拷贝次数:传统的数据传输方式通常需要进行多次数据拷贝,而零拷贝技术通过巧妙的设计,尽可能地减少了这种不必要的复制。例如,在某些实现方式中,数据可以直接在内核空间中进行传输,避免了在用户空间和内核空间之间的来回拷贝,将传统的 4 次拷贝减少到最少 0 次 CPU 拷贝。减少上下文切换次数:上下文切换是指 CPU 从一个任务切换到另一个任务时,需要保存和恢复任务的状态信息,这个过程会消耗一定的时间和资源。零拷贝技术通过减少系统调用的次数,从而减少了用户态和内核态之间的上下文切换次数。例如,传统的 I/O 操作需要 2 次系统调用(read/write),会导致 4 次用户态→内核态切换,而零拷贝技术可以将系统调用次数减少到 1 次,大大降低了上下文切换的开销。避免内存冗余占用:在传统的数据传输中,数据往往需要在用户空间缓冲区中重复存储,这不仅浪费了内存资源,还增加了数据管理的复杂性。零拷贝技术通过让数据直接在内核空间中流转,避免了数据在用户空间的重复存储,提高了内存的利用率。以 Linux 系统中的sendfile系统调用为例,这是一种常见的零拷贝实现方式。在使用sendfile时,数据可以直接从内核缓冲区传输到 socket 缓冲区,而不需要经过用户空间。具体过程如下:

用户态到内核态切换:应用程序调用sendfile系统调用,请求将文件数据发送到网络。CPU 从用户态切换到内核态。磁盘数据读取到内核缓冲区:内核通过 DMA 技术,将磁盘数据直接拷贝到内核缓冲区。内核缓冲区数据直接传输到 socket 缓冲区:内核直接将内核缓冲区中的数据传输到 socket 缓冲区,而不需要经过用户空间。这一步利用了内核的特殊机制,直接在内核空间中完成数据的传输,避免了数据在用户空间和内核空间之间的拷贝。socket 缓冲区数据发送到网卡:内核通过 DMA 技术,将 socket 缓冲区中的数据拷贝到网卡缓冲区,然后通过网络发送出去。内核态到用户态切换:sendfile系统调用返回,CPU 从内核态切换回用户态,数据传输完成。对比传统 I/O 和零拷贝技术的数据传输路径,可以明显看出零拷贝技术的优势。在传统 I/O 中,数据需要在用户空间和内核空间之间多次拷贝,而在零拷贝技术中,数据可以直接在内核空间中传输,减少了数据拷贝的次数和上下文切换的开销。这就好比在物流运输中,传统 I/O 就像是货物需要多次装卸、转运,而零拷贝技术则像是货物可以直接从起点运输到终点,中间不需要多次中转,大大提高了运输的效率。

避免数据拷贝:

避免操作系统内核缓冲区之间进行数据拷贝操作。避免操作系统内核和用户应用程序地址空间这两者之间进行数据拷贝操作。用户应用程序可以避开操作系统直接访问硬件存储。数据传输尽量让 DMA 来做。将多种操作结合在一起

避免不必要的系统调用和上下文切换。需要拷贝的数据可以先被缓存起来。对数据进行处理尽量让硬件来做。对于高速网络来说,零拷贝技术是非常重要的。这是因为高速网络的网络链接能力与 CPU 的处理能力接近,甚至会超过 CPU 的处理能力。

如果是这样的话,那么 CPU 就有可能需要花费几乎所有的时间去拷贝要传输的数据,而没有能力再去做别的事情,这就产生了性能瓶颈,限制了通讯速率,从而降低了网络连接的能力。一般来说,一个 CPU 时钟周期可以处理一位的数据。举例来说,一个 1 GHz 的处理器可以对 1Gbit/s 的网络链接进行传统的数据拷贝操作,但是如果是 10 Gbit/s 的网络,那么对于相同的处理器来说,零拷贝技术就变得非常重要了。

对于超过 1 Gbit/s 的网络链接来说,零拷贝技术在超级计算机集群以及大型的商业数据中心中都有所应用。然而,随着信息技术的发展,1 Gbit/s,10 Gbit/s 以及 100 Gbit/s 的网络会越来越普及,那么零拷贝技术也会变得越来越普及,这是因为网络链接的处理能力比 CPU 的处理能力的增长要快得多。传统的数据拷贝受限于传统的操作系统或者通信协议,这就限制了数据传输性能。零拷贝技术通过减少数据拷贝次数,简化协议处理的层次,在应用程序和网络之间提供更快的数据传输方法,从而可以有效地降低通信延迟,提高网络吞吐率。零拷贝技术是实现主机或者路由器等设备高速网络接口的主要技术之一。

现代的 CPU 和存储体系结构提供了很多相关的功能来减少或避免 I/O 操作过程中产生的不必要的 CPU 数据拷贝操作,但是,CPU 和存储体系结构的这种优势经常被过高估计。存储体系结构的复杂性以及网络协议中必需的数据传输可能会产生问题,有时甚至会导致零拷贝这种技术的优点完全丧失。在下一章中,我们会介绍几种 Linux 操作系统中出现的零拷贝技术,简单描述一下它们的实现方法,并对它们的弱点进行分析。

六、监控与调优:定位切换瓶颈

在 Linux 内核态的实现中,安全与效率就像是天平的两端,需要精心权衡和把握 。内核态作为操作系统的核心运行环境,肩负着管理系统资源、保障系统稳定运行的重任,其安全性和运行效率直接关系到整个系统的性能和稳定性。为了实现这一目标,Linux 内核在设计和实现过程中采用了一系列巧妙的策略和机制,这些策略和机制就像是经验丰富的工匠手中的精湛技艺,精准地平衡着安全与效率之间的关系。

6.1上下文隔离:用户态与内核态使用独立栈

在 Linux 系统中,用户态与内核态使用独立的栈空间,这是保障系统安全的重要防线 。内核栈通常大小为 8KB 或 16KB ,就像是一个独立的 “小仓库”,专门用于存储内核态运行时的相关信息,如函数调用栈、寄存器值等。当进程因中断或系统调用从用户态陷入内核态时,会立即切换到内核栈,就像一个人从普通房间进入了一个特殊的保密房间,所有的操作都在这个保密房间内进行。

在这个切换过程中,系统会严格校验地址合法性 ,其中 access_ok 函数就像是一个严格的 “安检员”,负责检查用户态指针是否可读 / 写 。例如,当用户态程序通过系统调用传递参数给内核时,access_ok 函数会仔细检查这些参数的地址是否在用户态的合法范围内,如果发现地址非法,就像安检员发现了危险物品,会立即阻止操作的进行,返回错误信息,防止恶意程序通过参数注入等手段攻击内核,确保内核态的安全性和稳定性。

在用户态与内核态切换时,上下文切换的成本主要体现在以下几个方面:

寄存器状态保存:寄存器是 CPU 内部用于临时存储数据的高速存储单元,在用户态运行时,寄存器中存储着程序运行的关键信息,比如 eax、ebx 等通用寄存器可能保存着函数的参数、返回值,程序计数器寄存器(eip ,在 x86 架构中)则指示着下一条要执行的指令地址 。当进行用户态到内核态的切换时,CPU 需要将这些寄存器的状态保存到内存中,因为内核态有自己的一套寄存器使用规则和数据处理方式,不能直接使用用户态的寄存器值。以一个简单的 C 语言函数调用系统调用 read () 为例,在调用 read () 之前,CPU 正在执行用户态程序,寄存器中保存着该程序的相关数据和指令地址。当 read () 触发系统调用,CPU 切换到内核态时,会将当前寄存器的状态压入到内核栈中保存起来。当内核态完成 read () 操作,准备返回用户态时,再从内核栈中取出之前保存的寄存器状态,重新加载到寄存器中,让用户态程序能够继续正确执行。这个保存和恢复寄存器状态的过程,虽然单次操作的时间很短,大约消耗数百纳秒,但在高并发场景下,频繁的切换会使这个时间累积起来,成为影响性能的一个重要因素 。栈空间切换:在用户态,每个进程都有自己独立的用户栈,用于函数调用、局部变量存储等操作;而在内核态,内核使用的是内核栈 。当用户态切换到内核态时,需要更新栈指针 esp(栈顶指针寄存器)和段寄存器 ss(栈段寄存器),以切换到内核栈。这一过程涉及到内存访问,因为要将用户栈的相关信息保存起来,并切换到内核栈的起始位置。而且,栈空间的切换还可能导致 TLB(Translation Lookaside Buffer,转换后备缓冲器)刷新 。TLB 是一种高速缓存,用于存储虚拟地址到物理地址的映射关系,以加快内存访问速度。当栈空间切换时,之前用户栈相关的 TLB 缓存可能不再有效,需要重新加载内核栈相关的映射关系,这就增加了内存访问的延迟,进一步影响了性能。例如,当一个网络服务器进程在处理大量客户端连接时,频繁地进行用户态与内核态的切换来处理网络请求和响应,每次切换都伴随着栈空间的切换和 TLB 刷新,这会导致大量的时间消耗在这些额外操作上,降低了服务器的整体性能 。内存空间隔离:正如前面提到的,用户态只能访问进程的虚拟地址空间(0 - 3GB,以 32 位系统为例),而内核态需要切换到内核地址空间(3 - 4GB)。这种内存空间的切换会导致页表缓存(TLB)失效 。因为 TLB 中缓存的是用户态虚拟地址到物理地址的映射关系,当切换到内核态时,地址空间发生了变化,原来的映射关系不再适用,需要重新查询页表来获取正确的映射关系,这就增加了内存访问的延迟。例如,当用户态程序调用 open () 函数打开一个文件时,会触发系统调用进入内核态,此时 CPU 需要切换到内核地址空间,查询内核的页表来获取文件相关的数据和操作函数的地址,这个过程中由于 TLB 失效,内存访问的延迟会显著增加,如果频繁进行这样的操作,就会对系统性能产生较大影响 。除了上下文切换本身的成本,高频的用户态与内核态切换还会引发一系列连锁反应,进一步降低系统性能 。

CPU 缓存污染:CPU 缓存是为了加速 CPU 对内存数据的访问而设计的,它分为 L1、L2、L3 等多级缓存 。在用户态和内核态频繁切换时,CPU 缓存中的数据会频繁地被置换。因为用户态和内核态访问的数据和代码不同,当从用户态切换到内核态时,内核态的数据和代码可能会替换掉用户态在缓存中暂存的数据,反之亦然 。这就导致缓存命中率降低,CPU 需要更多地从内存中读取数据,而内存访问速度远低于缓存访问速度,从而增加了整体的执行时间 。以一个数据库应用程序为例,它可能会频繁地进行文件读写操作,这些操作会触发用户态与内核态的切换。在切换过程中,原本缓存中用于数据库查询的数据可能会被内核态的文件系统相关数据替换掉,当数据库应用程序再次需要查询数据时,就无法从缓存中快速获取,只能从内存中读取,大大降低了查询效率 。调度延迟累积:大量的用户态与内核态切换会使内核调度器的负载加重 。内核调度器负责决定哪个进程或线程在 CPU 上执行,当切换频繁发生时,调度器需要不断地进行进程上下文切换、优先级判断等操作 。在高并发网络服务中,比如一个 Web 服务器,每一次 HTTP 请求的处理都可能触发数十次用户态与内核态的切换,从接收网络数据、解析 HTTP 请求,到读取文件返回响应内容等操作。这些频繁的切换会使内核调度器忙于处理上下文切换,导致进程的响应时间变长,累计的延迟可达毫秒级 。如果服务器同时处理大量的并发请求,这种延迟累积会严重影响服务器的性能,甚至导致服务响应缓慢,用户体验变差 。在内核态的关键路径上,严格禁止调用 sleep 等阻塞函数,这就像是在交通要道上禁止设置障碍物,确保道路的畅通无阻。因为一旦在内核态关键路径上调用了阻塞函数,就像在交通要道上突然设置了路障,可能会导致整个系统卡住,无法及时响应其他任务。

对于耗时操作,内核会通过异步机制(如中断下半部)来处理 ,就像是将一些耗时的工作交给专门的团队去异步处理,不影响主线程的运行。以网络数据包的接收为例,当网卡接收到数据包时,会触发硬件中断,内核首先在中断处理的上半部快速处理一些紧急事务,如标记数据包的到来;然后,将耗时较长的数据包处理工作放到中断下半部(如 tasklet 或工作队列)中异步执行,这样可以避免在中断处理过程中长时间占用 CPU,保证系统能够及时响应其他中断请求,提高系统的整体运行效率。

6.2性能分析工具

(1)perf 追踪切换事件:perf 是 Linux 系统中一款强大的性能分析工具,它能像一位专业的侦探一样,深入系统内部,精准地统计上下文切换次数。通过 perf record -e context-switches 命令,我们就像是给系统的上下文切换事件安装了一个 “记录仪”,它会详细记录下每次上下文切换的相关信息。之后,再配合 perf report 命令,就如同打开了一份详细的调查报告,我们可以清晰地定位到高频切换的进程和函数 。

在一个复杂的数据库应用程序中,通过 perf 追踪发现,在数据查询高峰期,一个负责数据缓存管理的进程频繁进行上下文切换,占用了大量的 CPU 时间。进一步查看 perf report 的结果,发现该进程中的一个缓存更新函数,由于设计不合理,每次更新缓存时都会触发多次系统调用,从而导致了高频的上下文切换 。通过优化这个函数,减少了不必要的系统调用,成功降低了上下文切换次数,提升了系统性能 。

(2)vmstat 实时监控:vmstat 命令则像是一个实时的系统状态监控仪表盘,通过它,我们可以实时观察到系统的各种关键指标,其中 cs(上下文切换次数)和 in(中断次数)指标尤为重要 。当 cs 指标的值超过 10 万次 / 秒时,就像是一个红色警报灯亮起,提示我们系统可能存在切换瓶颈 。

在一个高并发的 Web 服务器环境中,通过 vmstat 实时监控发现,随着并发用户数的增加,cs 指标迅速攀升,一度超过了 15 万次 / 秒,同时 in 指标也显著上升 。这表明系统正面临着巨大的压力,频繁的上下文切换和中断处理严重影响了服务器的性能 。进一步排查发现,是服务器的网络驱动程序存在问题,导致网络中断处理效率低下,进而引发了大量的上下文切换 。通过更新网络驱动程序,优化中断处理逻辑,cs 指标降至 5 万次 / 秒以下,服务器性能得到了明显改善 。

6.3内核参数优化

(1)调整调度策略:不同的调度策略就像是不同的交通规则,会影响进程在 CPU 上的执行顺序和时间分配 。对于实时性任务,比如一些工业控制系统中的数据采集任务,对时间要求极高,必须在极短的时间内完成数据采集和处理,否则可能会导致严重的后果 。此时,我们可以使用 SCHED_FIFO 调度类,它就像是给这些实时性任务颁发了一张 “VIP 通行证”,让它们能够优先获得 CPU 资源,减少不必要的调度切换 。

在一个自动化工厂的控制系统中,数据采集任务需要在 1 毫秒内完成数据采集和初步处理,以确保生产线的正常运行 。通过将数据采集任务的调度策略设置为 SCHED_FIFO,该任务能够及时获得 CPU 资源,避免了因调度切换而产生的延迟,保证了生产线的稳定运行 。

(2)优化中断亲和性:中断亲和性的优化就像是给设备中断安排了专属的 “办公地点”,通过将设备中断绑定到特定 CPU 核心,可以避免跨核心切换带来的缓存失效问题 。我们可以通过 echo <cpu_list> > /proc/irq/<irq_number>/smp_affinity 这条命令,将特定的设备中断绑定到指定的 CPU 核心 。

在一个配备多块网卡的网络服务器中,每个网卡都会产生大量的中断 。如果这些中断随机分配到不同的 CPU 核心上处理,就会导致频繁的跨核心切换,使缓存中的数据频繁失效,大大降低了处理效率 。通过将每个网卡的中断分别绑定到不同的 CPU 核心上,让每个 CPU 核心专注处理特定网卡的中断,减少了跨核心切换,提高了缓存利用率,网络数据的处理速度提升了 30% 。

七、实战演示:用 /proc 接口实现双向数据交互

理论知识讲了这么多,接下来我们进入实战环节,通过一个具体的示例,来看看如何利用 /proc 文件系统实现内核态与用户态的双向数据交互。这个示例就像是一个实际的项目,让我们把之前学到的知识运用起来,真正掌握内核态与用户态交互的技巧。

7.1实验环境准备

(1)内核版本:建议选择 Linux 5.10 ,它具有较好的兼容性和稳定性,就像是一座坚固的大厦,为我们的实验提供了可靠的基础。我们可以使用 Ubuntu 20.04 LTS 系统,它就像是一个功能齐全的实验室,预装了许多常用的开发工具和库,方便我们进行实验。

(2)开发工具:

gcc:这是一款强大的编译器,就像是一个勤劳的工匠,能够将我们编写的 C 语言代码编译成可执行文件。我们可以通过sudo apt install build-essential命令来安装它 。make:它是一个构建自动化工具,就像是一个高效的项目经理,能够根据 Makefile 文件中的规则,自动编译和构建项目。在安装build-essential时,它会被一并安装。内核头文件:这些头文件就像是一本本技术手册,包含了内核编程所需的各种定义和声明。我们可以通过sudo apt install linux-headers-$(uname -r)命令来安装,其中$(uname -r)会自动获取当前系统的内核版本 。(3)内核模块开发详解

首先,我们来编写内核模块代码myproc.c,它就像是一个连接内核态和用户态的桥梁建造蓝图。

在这段代码中,我们定义了myproc_read和myproc_write函数,分别用于处理用户态的读和写请求 。就像是两个忙碌的快递员,一个负责把数据从内核态发送到用户态,另一个负责把数据从用户态接收并存储到内核态。myproc_init函数在模块加载时被调用,它创建了/proc/myproc文件节点 ,就像是在 “交互窗口” 上开了一扇新的窗户。myproc_exit函数在模块卸载时被调用,它删除了这个文件节点 ,就像是关闭了这扇窗户。

7.2用户态测试程序

接下来,我们编写用户态测试程序user_test.c,它就像是一个与内核态进行对话的使者。

在这个程序中,我们首先打开/proc/myproc文件 ,就像是敲响了内核态的大门。然后,向文件中写入数据 “Hello, kernel!” ,就像是给内核态送去了一封信。接着,读取文件中的数据 ,看看内核态给我们回复了什么。最后,关闭文件 ,结束这次对话。

7.3编译运行与调试

(1)编写 Makefile 编译内核模块:

这个 Makefile 就像是一份详细的施工计划,告诉make工具如何编译内核模块。其中,obj-m += myproc.o表示要编译myproc.c文件生成myproc.ko内核模块 。make -C /lib/modules/$(shell uname -r)/build M=$(PWD) modules命令表示切换到内核源码目录进行编译,然后返回当前目录 。make -C /lib/modules/$(shell uname -r)/build M=$(PWD) clean命令用于清理编译生成的文件 。

(2)加载模块:使用sudo insmod myproc.ko命令加载内核模块 ,就像是把建造好的桥梁安装到合适的位置,让内核态和用户态能够开始通信。

(3)运行用户程序:执行sudo./user_test命令运行用户态测试程序 ,就像是派出使者与内核态进行对话,看看双向数据交互是否正常。

(4) 查看内核日志:通过dmesg | grep myproc命令查看内核日志 ,就像是查看通话记录,看看内核态接收到用户态的数据后,做了哪些处理。如果一切正常,我们应该能看到内核打印出 “Received from user: Hello, kernel!” 这样的日志信息 。